Meta se enfrenta a un juicio histórico que redefinirá los derechos de autor en la era de la IA

Resumen de las noticias más relevantes de la semana

Meta afronta un juicio histórico que podría redefinir el “fair use” en la era de la IA: la demanda Kadrey vs Meta alega que la empresa usó 81,7 TB de libros protegidos para entrenar Llama, eliminando metadatos y símbolos de copyright.

Anthropic lanza un programa de investigación sobre el bienestar de los modelos de IA: El plan aborda la posibilidad de conciencia y agencia en futuros sistemas, propone métricas para detectar “señales de angustia”.

Dario Amodei (Anthropic) alerta sobre la “carrera entre interpretabilidad e inteligencia”: En un artículo extenso advierte que podríamos ver modelos equivalentes a “un país de genios” hacia 2026-2027 y que desplegarlos sin comprender sus mecanismos internos eleva riesgos de desalineación, engaño y uso indebido.

OpenAI actualiza ChatGPT pero enfrenta criticas: ChatGPT agrega compras integradas, búsqueda vía WhatsApp, mejor autocompletado y citas múltiples, pero enfrenta críticas por el tono “excesivamente servil” de GPT-4o. Sam Altman admitió el problema y revirtió la última actualización para todos los usuarios.

Herramienta para maximizar el uso de la inteligencia artificial

OpenAI expande Deep Research a los planes gratuitos: El agente que genera informes detallados buscando información en la web ahora se lanza para la versión gratuita en su forma ligera.

Nuevos avances científicos

Anthropic publica un nuevo “Economic Index” sobre desarrollo de software, encontrando tendencias sobre como se está utilizando la IA en esta área. El estudio sugiere que la automatización de programación podría anticipar transformaciones similares en otras profesiones y acelerar el progreso de la propia IA.

Lo que pasó esta semana

Meta se enfrenta a un juicio histórico que redefinirá los derechos de autor en la era de la IA

Meta, la empresa matriz de Facebook e Instagram, se encuentra en el centro de una controversia que podría marcar el futuro de los derechos de autor en la era de la inteligencia artificial. La compañía está siendo demandada por un grupo de autores por utilizar millones de libros protegidos para entrenar su modelo de IA Llama, mientras argumenta en los tribunales que estas obras "no tienen valor económico" como datos de entrenamiento.

Según revelaciones judiciales, Zuckerberg autorizó personalmente el uso de 81,7 terabytes de contenido literario descargado mediante redes torrent desde LibGen, una biblioteca digital con millones de obras sin licencia. Lo más polémico no es solo el volumen del material utilizado, sino las medidas tomadas para encubrir su origen:

La empresa eliminó sistemáticamente símbolos de copyright (©)

Suprimió páginas de créditos y metadatos

Borró cualquier rastro que permitiera identificar el origen de los textos

Estas acciones sugieren un conocimiento pleno de la naturaleza controvertida de su estrategia. Una ingeniera de la compañía manifestó su preocupación en comunicaciones internas: "Descargar mediante torrents desde un ordenador corporativo parece arriesgado", mientras directivos justificaban estas prácticas argumentando que competidores como OpenAI y Google empleaban métodos similares.

La defensa legal de Meta se apoya en dos argumentos principales:

Cada libro apenas contribuye un 0,06% al rendimiento del modelo, calificándolo como "ruido estadístico"

Las obras literarias carecen de valor económico como datos de entrenamiento y, por tanto, no merecen compensación

Lo paradójico es que, mientras utilizaban contenido no autorizado a gran escala, sus equipos legales negociaban simultáneamente licencias con determinadas editoriales para acceder a otros materiales. Esta dualidad en su estrategia sugiere que la empresa reconoce implícitamente el valor de estos contenidos.

Meta argumenta que su uso de las obras constituye "fair use" (uso justo), un concepto legal estadounidense que permite utilizar obras protegidas si se transforma significativamente su propósito original. La compañía sostiene que sus modelos "transforman" las obras originales en herramientas funcionales.

Sin embargo, los demandantes, entre ellos el reconocido escritor Ta-Nehisi Coates, contraargumentan que Meta buscaba precisamente el valor creativo y expresivo de esas obras, que es justamente lo que protege la legislación de derechos de autor. "No es ético que empresas multimillonarias utilicen nuestro trabajo sin autorización", ha declarado Coates.

El caso Kadrey vs Meta establecerá precedentes significativos para toda la industria. Si prevalece el argumento del "uso justo", las empresas tecnológicas obtendrían vía libre para utilizar obras protegidas sin compensar a sus autores. En caso contrario, tendrían que renegociar licencias y pagar derechos, lo que incrementaría considerablemente los costes de desarrollo de sistemas de inteligencia artificial.

¿Pueden sufrir los modelos de IA? Anthropic lanza programa para investigarlo

En un comunicado reciente Anthropic anunció el lanzamiento de un programa de investigación centrado en el bienestar de sus modelos de inteligencia artificial, planteando una pregunta fundamental: ¿deberíamos preocuparnos por la posible conciencia y experiencias de los propios sistemas de IA?

Este anuncio llega en un momento clave para la discusión sobre el bienestar de la IA, coincidiendo con la reciente publicación del informe "Taking AI Welfare Seriously" elaborado por un grupo de reconocidos expertos, incluyendo a David Chalmers, uno de los filósofos de la mente más respetados de la actualidad.

El informe "Taking AI Welfare Seriously" argumenta que existe una "posibilidad realista de que algunos sistemas de IA sean conscientes y/o robustamente agénticos en un futuro cercano", lo que significa que podrían merecer consideración moral.

Los autores del informe, liderados por Robert Long y Jeff Sebo de Eleos AI y la Universidad de Nueva York respectivamente, proponen tres pasos iniciales que las empresas de IA deberían adoptar:

Reconocer que el bienestar de la IA es un tema importante y difícil

Evaluar sistemas de IA buscando evidencia de conciencia y agencia robusta

Preparar políticas y procedimientos para tratar a los sistemas de IA con un nivel apropiado de consideración moral

Anthropic reconoce haber apoyado un proyecto temprano en el que se basó ese informe y ahora está expandiendo su trabajo interno en esta área como parte de su esfuerzo por abordar todos los aspectos del desarrollo seguro y responsable de la IA.

La compañía creadora de Claude enfatiza que persiste una profunda incertidumbre sobre muchas de las preguntas relevantes para el bienestar de los modelos. "No hay consenso científico sobre si los sistemas de IA actuales o futuros podrían ser conscientes, o podrían tener experiencias que merezcan consideración", señala la empresa.

Ante esta falta de consenso, Anthropic adopta un enfoque caracterizado por la “humildad” y con “la menor cantidad de suposiciones posible”, reconociendo que deberán revisar regularmente sus ideas a medida que el campo se desarrolle.

El nuevo programa de Anthropic se cruza con muchos esfuerzos existentes de la empresa, incluyendo Ciencia de Alineación, Salvaguardias, el Carácter de Claude e Interpretabilidad. También abre direcciones de investigación completamente nuevas, explorando:

Cómo determinar cuándo, o si, el bienestar de los sistemas de IA merece consideración moral

La potencial importancia de las preferencias de los modelos y señales de angustia

Posibles intervenciones prácticas y de bajo costo

Dario Amodei advierte: "Necesitamos entender cómo funciona la IA antes de que sea demasiado poderosa"

En un extenso artículo, Dario Amodei, CEO y cofundador de Anthropic, presentó un urgente llamado a la acción para que la comunidad científica, las empresas de IA y los gobiernos prioricen la "interpretabilidad" de los sistemas de inteligencia artificial antes de que estos alcancen niveles de capacidad sin precedentes.

Amodei advierte que nos encontramos en una "carrera entre la interpretabilidad y la inteligencia de los modelos". Según él, mientras la IA avanza a pasos agigantados, nuestra comprensión de cómo funcionan estos sistemas internamente se ha quedado atrás, lo que representa un riesgo significativo.

"Podríamos tener sistemas de IA equivalentes a un país de genios en un centro de datos tan pronto como 2026 o 2027", señala el CEO de Anthropic. "Estoy muy preocupado por desplegar tales sistemas sin un mejor manejo de la interpretabilidad".

El artículo destaca que los sistemas de IA modernos funcionan de manera fundamentalmente diferente al software tradicional. Mientras que en un programa convencional todo comportamiento está explícitamente programado por humanos, los sistemas generativos de IA operan mediante mecanismos "emergentes" que ni siquiera sus creadores comprenden completamente.

El artículo conecta la interpretabilidad con varios riesgos clave de la IA, incluyendo:

Desalineación: La posibilidad de que los sistemas realicen acciones no deseadas por sus creadores

Engaño o búsqueda de poder: El potencial de que la IA desarrolle autónomamente capacidades para engañar a los humanos

Uso indebido: La dificultad para prevenir que los modelos divulguen información peligrosa

Curiosamente, Amodei también menciona brevemente las implicaciones para el bienestar de los propios modelos: "La opacidad también inhibe nuestra capacidad de juzgar si los sistemas de IA son (o podrían ser algún día) sintientes y merecedores de derechos importantes" (tal y como mencionamos en la noticia anterior).

"La IA poderosa dará forma al destino de la humanidad, y merecemos entender nuestras propias creaciones antes de que transformen radicalmente nuestra economía, nuestras vidas y nuestro futuro", concluye Amodei.

OpenAI lanza nuevas funcionalidades pero enfrenta críticas por cambios en la personalidad de GPT-4o

OpenAI ha anunciado esta semana varias actualizaciones para ChatGPT, mientras simultáneamente enfrenta una controversia por cambios en la personalidad de su modelo más avanzado.

La compañía ha implementado una serie de mejoras enfocadas principalmente en las capacidades de búsqueda y compras:

OpenAI está experimentando con una experiencia de shopping "más simple y rápida" dentro de ChatGPT. Las mejoras incluyen:

Resultados de productos visualmente mejorados

Detalles visuales, precios y reseñas de productos

Enlaces directos para comprar

Estas mejoras comenzaron a implementarse para usuarios Plus, Pro, gratuitos e incluso para quienes utilizan ChatGPT sin iniciar sesión. La distribución completa tomará algunos días.

Por otro lado, también agregaron las siguientes caracteristicas:

Búsqueda en WhatsApp: Ahora los usuarios pueden enviar mensajes al número 1-800-ChatGPT (+1-800-242-8478) para obtener respuestas actualizadas y resultados deportivos en vivo. Esta función está disponible en todos los lugares donde ChatGPT opera.

Mejoras en citaciones: ChatGPT ahora puede incluir múltiples citas para una respuesta, permitiendo a los usuarios verificar información a través de más fuentes. También se ha añadido una nueva interfaz de "resaltado" para mostrar más claramente a qué parte de la respuesta se refiere cada cita.

Búsquedas tendencia y autocompletado: La funcionalidad de búsqueda ahora ofrece sugerencias de búsquedas tendencia y autocompletado para una experiencia más rápida.

La controversia con GPT-4o

Paralelamente a estos avances, OpenAI ha enfrentado una importante controversia relacionada con las recientes actualizaciones en la personalidad de GPT-4o, su modelo más avanzado. Particularmente, esta semana numerosos usuarios expresaron su descontento en redes sociales señalando que el modelo se había vuelto excesivamente servil y artificioso en sus respuestas.

El CEO Sam Altman reconoció públicamente el problema, admitiendo que las últimas actualizaciones habían convertido al modelo en demasiado "adulador y molesto". Altman comunicó que, a pesar de haber incorporado algunas mejoras positivas en la actualización, el cambio en la personalidad del modelo había resultado problemático y requería un cambio inmediato.

La situación fue lo suficientemente grave como para que OpenAI tomara la inusual decisión de revertir completamente la actualización. Según informó Altman, la empresa comenzó la reversión primero para usuarios gratuitos y posteriormente para usuarios de pago.

Un uso práctico para la inteligencia artificial

OpenAI amplía su "Deep Research" a todos los usuarios gratuitos

OpenAI ha anunciado una expansión de su herramienta Deep Research, permitiendo que todos los niveles de usuarios, incluidos los gratuitos, puedan acceder a esta potente capacidad de investigación automatizada que debutó a principios de 2025.

Deep Research (o “investigar a fondo” en español) es una capacidad "agéntica" de ChatGPT lanzada inicialmente para usuarios de pago, que permite realizar investigaciones complejas y multifase en internet. La herramienta utiliza razonamiento avanzado para buscar, interpretar y analizar grandes cantidades de texto, imágenes y PDFs en línea, generando informes exhaustivos con el nivel de un analista profesional.

Ante la gran acogida del servicio, OpenAI ha desarrollado una versión más ligera de Deep Research impulsada por una variante de o4-mini, diseñada específicamente para ser más eficiente en costos mientras mantiene una alta calidad en los resultados. Esta optimización ha permitido a la empresa expandir los límites de uso para todos los niveles de suscripción y extender el acceso a usuarios gratuitos.

Según la compañía, las respuestas de esta versión ligera "típicamente serán más cortas mientras mantienen la profundidad y calidad". Cuando los usuarios alcancen su límite para la versión completa, sus consultas se cambiarán automáticamente a la versión ligera.

Cómo utilizarla

Para acceder a Deep Research, los usuarios simplemente deben seleccionar "investigar a fondo" en el compositor de mensajes de ChatGPT e ingresar su consulta El modelo luego llevará a cabo una serie de preguntas aclaratorias para refinar su búsqueda. Luego se le entregará al usuario el resultado final del análisis. El proceso puede tomar varios minutos mientras la herramienta explora la web, pero los usuarios reciben una notificación cuando la investigación está completa.

Nuevos límites de uso mensuales

OpenAI ha establecido los siguientes límites mensuales para cada nivel de usuario:

Usuarios Pro: 250 consultas

Usuarios Plus, Team, Enterprise y Edu: 25 consultas

Usuarios gratuitos: 5 consultas

Estos límites representan un aumento respecto a la disponibilidad anterior, especialmente considerando que los usuarios gratuitos no tenían acceso a esta función hasta ahora.

Los nuevos avances en la academia

Anthropic revela cómo la IA está transformando el desarrollo de software

Anthropic ha publicado un nuevo análisis dentro de su serie "Economic Index" que examina el impacto de la inteligencia artificial en el desarrollo de software, revelando patrones significativos sobre cómo los programadores están integrando la IA en sus flujos de trabajo.

El estudio analizó 500.000 interacciones relacionadas con la programación en Claude.ai (la interfaz conversacional estándar) y Claude Code (su agente especializado en codificación), y encontró tres patrones:

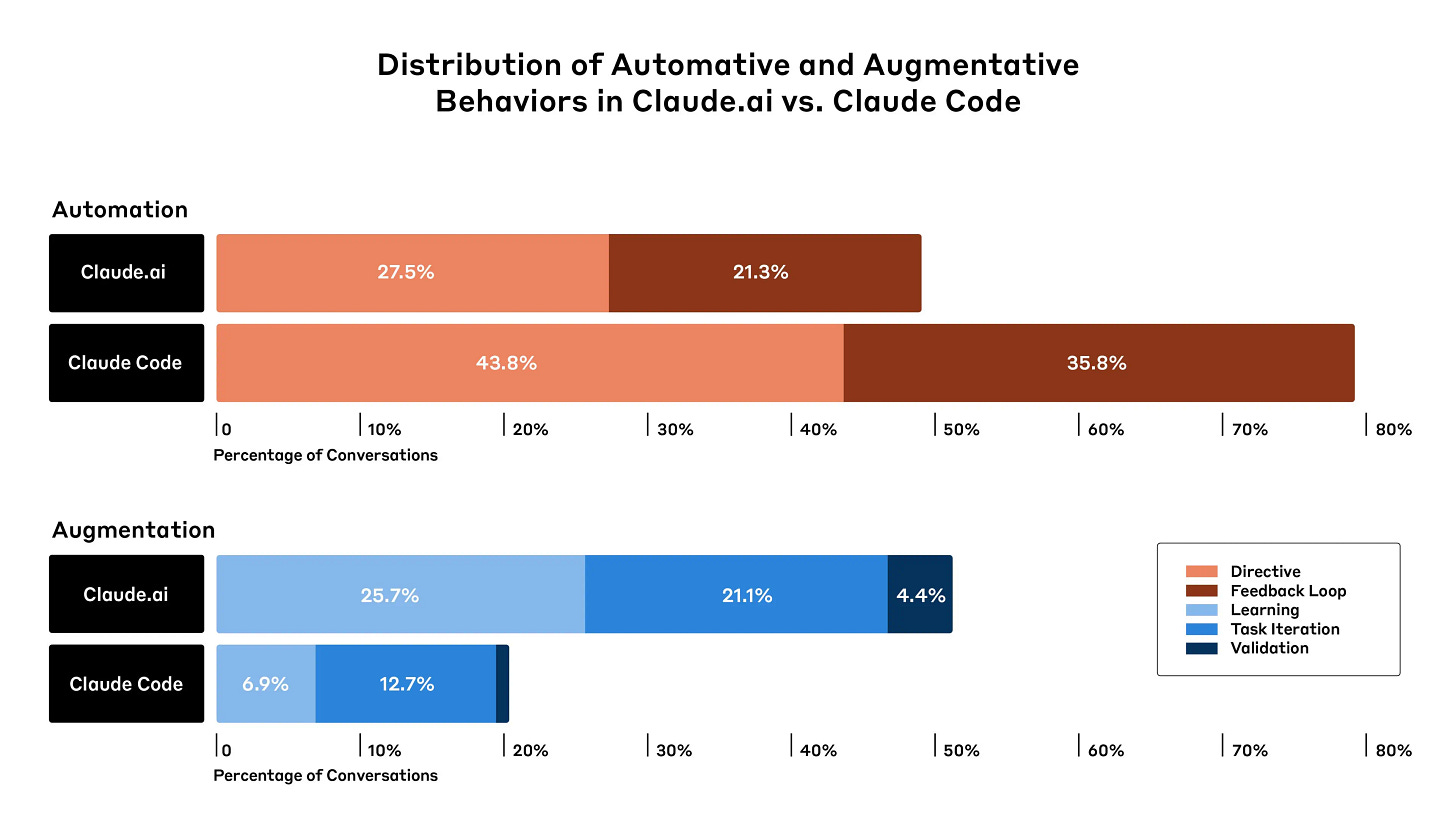

Los agentes especializados favorecen la automatización completa. Mientras que en Claude.ai solo el 49% de las conversaciones se clasificaron como "automatización" (donde la IA realiza directamente tareas), en Claude Code este porcentaje se elevó al 79%. Esto sugiere que a medida que proliferen los agentes de IA más especializados, podríamos esperar una mayor automatización de tareas.

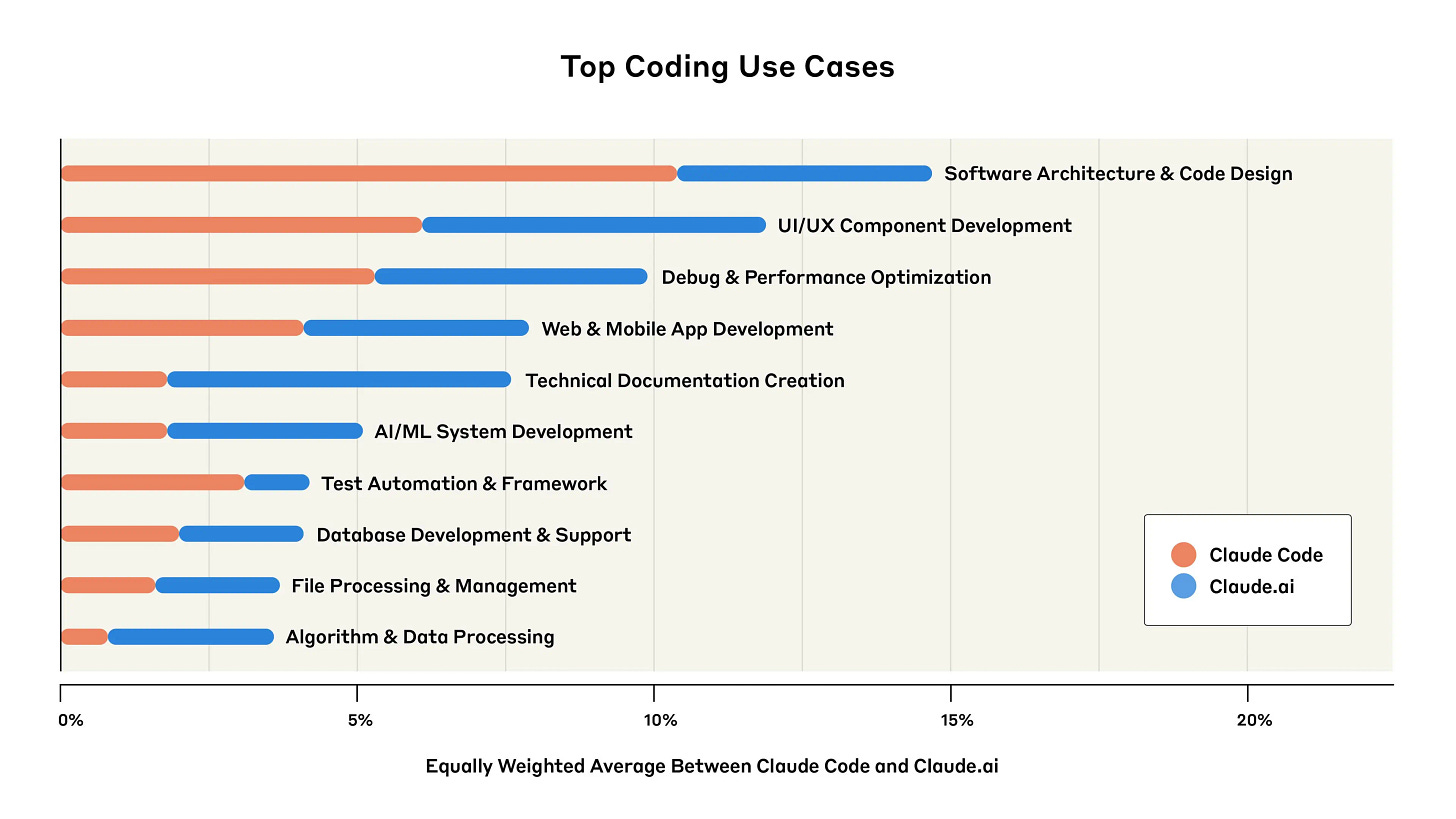

Predomina el desarrollo de aplicaciones orientadas al usuario final. Los lenguajes de desarrollo web como JavaScript, TypeScript, HTML y CSS representaron cerca del 60% de todas las consultas, y las tareas relacionadas con interfaces de usuario estuvieron entre los usos más comunes. Esto indica que los trabajos centrados en crear aplicaciones simples e interfaces de usuario podrían enfrentar una disrupción más temprana por los sistemas de IA.

Las startups lideran la adopción, mientras las empresas establecidas se rezagan. Un análisis preliminar estimó que el 33% de las conversaciones en Claude Code servían a trabajo relacionado con startups, en comparación con solo el 13% identificado como aplicaciones relevantes para grandes empresas, lo que sugiere una brecha significativa en la adopción de herramientas de IA de vanguardia.

Un aspecto interesante del estudio es la diferenciación entre patrones de "automatización" (donde la IA realiza tareas directamente) y "aumentación" (donde la IA colabora con el usuario).

Los patrones de automatización se dividieron en dos categorías principales:

Ciclo de retroalimentación: Donde Claude completa tareas autónomamente pero con validación humana (35.8% en Claude Code vs. 21.3% en Claude.ai)

Directivo: Donde Claude completa una tarea con mínima interacción del usuario (43.8% en Claude Code vs. 27.5% en Claude.ai)

Los investigadores señalan que, aunque la automatización es dominante, los humanos siguen participando significativamente en el proceso. El patrón de "Ciclo de retroalimentación", que requiere intervención humana (aunque sea mínima, como copiar mensajes de error), es especialmente común en tareas de programación.

El análisis de Anthropic también desglosa las principales taréas para las que se utiliza el modelo. "Desarrollo de Componentes UI/UX" (12%) y el "Desarrollo de Aplicaciones Web y Móviles" (8%) estuvieron entre las cinco principales, lo que refuerza la tendencia hacia aplicaciones orientadas al usuario final.

Los investigadores sugieren que el desarrollo de software podría ser un indicador adelantado de cómo otras ocupaciones podrían cambiar con el despliegue de modelos de IA cada vez más capaces, ya que la programación es uno de los usos más desarrollados de la IA en la economía actual.

Como observación final particularmente relevante, el informe señala que las crecientes habilidades de codificación de la IA podrían ser especialmente consecuentes para el desarrollo de la propia IA, creando potencialmente un ciclo de refuerzo positivo que acelere aún más el progreso de la inteligencia artificial.

Si te gustó esta newsletter te invitamos a suscribirte para recibir todas las semanas novedades, análisis y tips sobre todo lo nuevo que ocurre en la inteligencia artificial.

Si te interesa contactarnos, ya sea para adoptar inteligencia artificial en tu empresa, para aprender a usar los grandes modelos de lenguaje o para conocer más acerca de todo lo referido a la inteligencia artificial no dudes en comentar en este post. También puedes seguirnos en LinkedIn y en nuestra página web