Resumen de las noticias más relevantes de la semana

Google ante 2025: Sundar Pichai advierte que será un año crucial. Google apuesta por escalar Gemini a 500 millones de usuarios y consolidarse en la carrera por la IA.

DeepSeek V3 irrumpe con fuerza: La compañía china lanza un modelo de IA de frontera que supera a Claude 3.5 y GPT-4 en varios aspectos, con una fracción del presupuesto.

OpenAI y Microsoft definen la AGI en dólares: Ambas compañías establecen que se alcanzará AGI cuando se logren $100 mil millones en beneficios anuales.

Sam Altman proyecta el futuro de la IA: Predice transformaciones significativas hacia 2026, aunque asegura que los impulsos humanos no cambiarán.

Herramienta para maximizar el uso de la inteligencia artificial

"There’s an AI for That": Directorio que cataloga herramientas de IA por categorías, facilitando la búsqueda de aplicaciones específicas.

Nuevos avances científicos

Anthropic publica guía para construir agentes de IA: La empresa detrás de Claude revela patrones simples y efectivos para desarrollar agentes autónomos.

Lo que pasó esta semana

Google ante 2025: Una carrera contra el tiempo en la era de la IA

Sundar Pichai, CEO de Google, ha dejado clara la postura de la compañía para 2025 en una reciente reunión estratégica: la urgencia es máxima. En un momento donde la empresa enfrenta una competencia sin precedentes y grandes desafíos regulatorios, Google se prepara para lo que podría ser el año más crucial de su historia reciente.

"2025 será crítico", afirmó Pichai durante la reunión. "Es realmente importante que internalicemos la urgencia de este momento y necesitamos movernos más rápido como compañía. Los momentos disruptivos requieren enfoque implacable para desbloquear los beneficios de esta tecnología y resolver problemas reales de los usuarios."

Esta declaración llega en un contexto particularmente desafiante para el gigante tecnológico. Por un lado, Google enfrenta una presión regulatoria: un juez federal dictaminó que la empresa mantiene ilegalmente un monopolio en el mercado de búsquedas, mientras que el Departamento de Justicia solicitó la desinversión de su unidad Chrome. Por otro lado, la competencia en IA se intensifica con OpenAI, que alcanzó una valuación de $157 mil millones y anunció planes para lanzar su propio motor de búsqueda.

La respuesta de Google ante estos desafíos se centra en Gemini, su modelo de IA más avanzado. La compañía ve en la aplicación Gemini su próximo producto estrella, con el ambicioso objetivo de alcanzar los 500 millones de usuarios, uniéndose al selecto grupo de 15 aplicaciones de Google que han alcanzado esta marca.

"Escalar Gemini en el lado del consumidor será nuestro mayor enfoque el próximo año", enfatizó Pichai, reconociendo que aunque no siempre es necesario ser el primero, es crucial "ejecutar bien y realmente ser el mejor en su clase como producto".

Demis Hassabis, cofundador de DeepMind, reveló planes ambiciosos para "turbo charge" la aplicación Gemini, describiendo la visión de un asistente universal capaz de operar sin problemas en cualquier dominio, modalidad o dispositivo. Esta visión representa un cambio fundamental en la estrategia de Google, pasando de ser principalmente un motor de búsqueda a convertirse en un asistente AI omnipresente.

Lo más revelador de estas declaraciones es el reconocimiento implícito de Google de que ChatGPT les ha tomado la delantera en términos de percepción pública. Un empleado señaló que "ChatGPT se está volviendo sinónimo de IA de la misma manera que Google lo es de búsqueda", quedó clara la preocupación de la empresa por mantener su posición de liderazgo en la era de la IA.

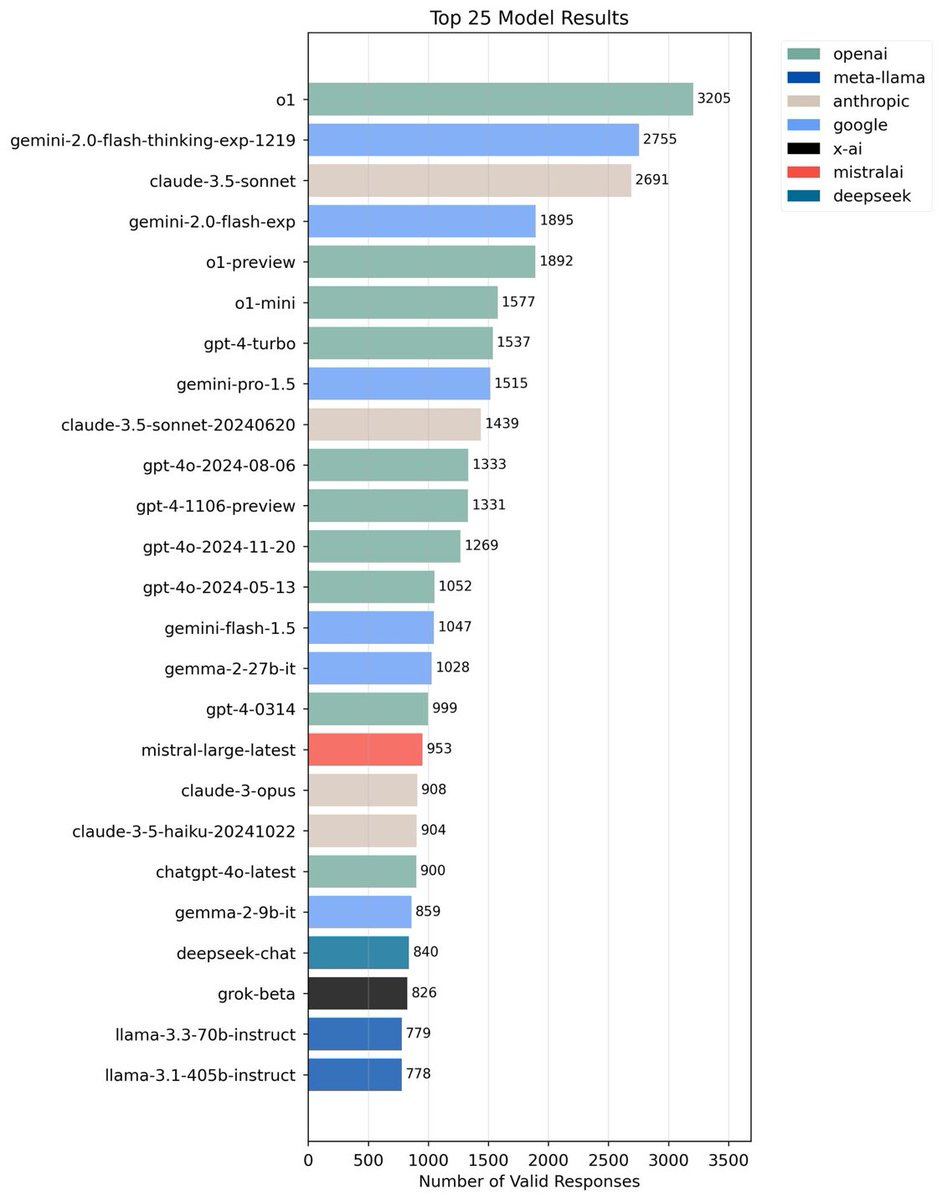

Sin embargo, a pesar de que ChatGPT es más conocido, recordemos que recientemente Google lanzo su nuevo modelo, Gemini 2.0 Flash Thinking (similar a la familia de modelos “o” de OpenAI), que se encuentra actualmente entre los mejores modelos de la actualidad.

Una empresa China lanza un modelo de frontera a una fracción del costo

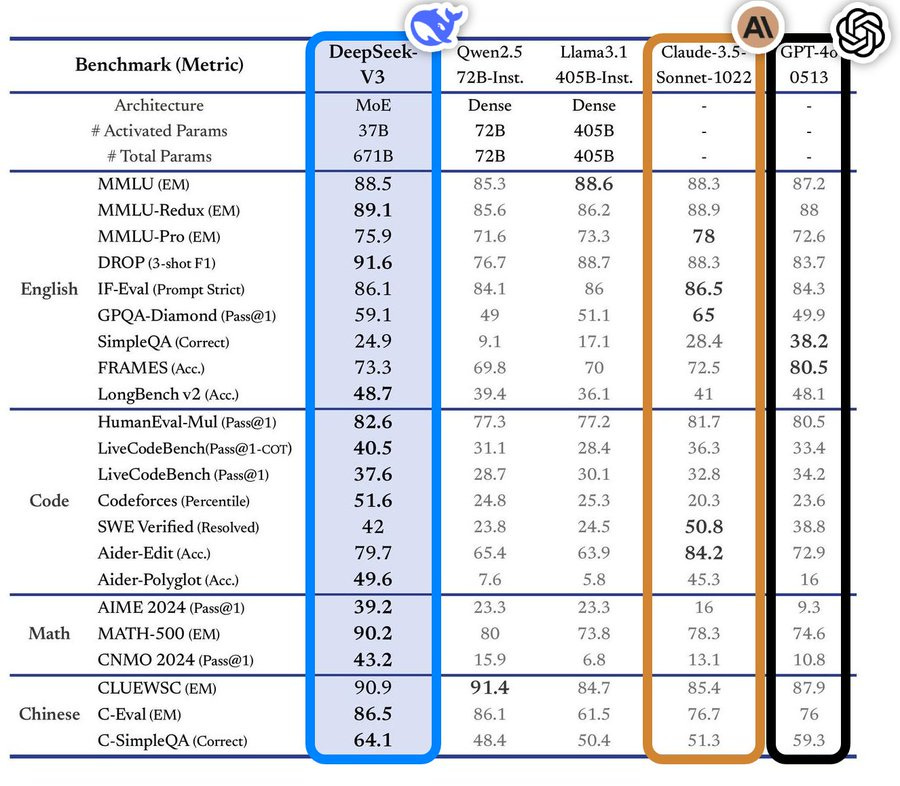

Una compañía china acaba de demostrar que la democratización de la IA de frontera es posible. DeepSeek ha lanzado su modelo V3, un sistema de código abierto que no solo compite con los gigantes propietarios como GPT-4 y Claude 3.5, sino que en varios aspectos los supera, y lo más sorprendente: lo ha logrado con una fracción del presupuesto habitualmente considerado necesario.

Los números son asombrosos: DeepSeek V3 ha conseguido resultados superiores a Claude 3.5 Sonnet en varias métricas clave, especialmente en programación. El modelo sobresale en pruebas como LiveCodeBench, donde alcanza un 40.5% frente al 36.3% de Claude, y en Aider-Edit, con un impresionante 79.7% contra el 84.2% de su competidor.

Lo verdaderamente revolucionario no son solo estos resultados, sino cómo se lograron. DeepSeek V3 fue entrenado con un presupuesto de apenas $5.5 millones, utilizando 2,048 GPUs durante dos meses. Para poner esto en perspectiva, modelos similares típicamente requieren clústeres de 16,000 GPUs o más. Por ejemplo, Llama 3 405B utilizó 30.8 millones de horas-GPU, mientras que DeepSeek V3 logró mejores resultados con solo 2.8 millones de horas-GPU, es decir, usando 11 veces menos poder computacional.

Esta hazaña desafía la creencia común de que se necesitan recursos masivos para desarrollar IAs de frontera. El éxito de DeepSeek demuestra que la innovación y la eficiencia pueden compensar las limitaciones presupuestarias. Su enfoque se centró en optimizar tanto los algoritmos como el uso de datos, logrando más con menos.

Se puede utilizar el modelo de manera gratuita a través del siguiente link.

OpenAI y Microsoft definen la AGI en dólares

En un nuevo avance en la carrera por la Inteligencia Artificial General (AGI), nuevos documentos revelados por The Information han expuesto la peculiar métrica que OpenAI y Microsoft han establecido para definir cuándo se habrá alcanzado la AGI: un beneficio anual de 100.000 millones de dólares. Recordemos que Microsoft es el principal inversionista de OpenAI, a pesar de que la relación entre ambas compañías no está en los mejores terminos.

La Inteligencia Artificial General (AGI) representa el santo grial del campo de la IA: un sistema capaz de comprender, aprender y aplicar conocimientos de manera similar o superior a los humanos en cualquier tarea. A diferencia de la IA actual, que está especializada en tareas específicas (como jugar al ajedrez o generar imágenes), una AGI podría transferir conocimientos entre dominios, razonar abstractamente, y resolver problemas nuevos sin entrenamiento previo específico.

Es el punto en el que una IA puede, en teoría, igualar o superar la inteligencia humana en todas sus facetas: desde la resolución de problemas matemáticos complejos hasta la comprensión de matices emocionales y culturales, desde la creatividad artística hasta el razonamiento científico. Sin embargo, definir exactamente cuándo se alcanzará este hito ha sido objeto de intenso debate en la comunidad científica. Mientras algunos argumentan que se necesita una comprensión verdadera y consciente del mundo, otros, como vemos en el caso de OpenAI y Microsoft, han optado por métricas más pragmáticas y cuantificables, aunque quizás menos filosóficamente satisfactorias.

Esta revelación arroja luz sobre la compleja relación entre ambas compañías y plantea interrogantes fundamentales sobre la comercialización de la IA. Mientras el debate académico sobre la AGI se ha centrado tradicionalmente en capacidades cognitivas y técnicas, esta definición puramente financiera sugiere un enfoque marcadamente diferente por parte de dos de los actores más influyentes en el campo.

La cifra no es casual. Para ponerla en perspectiva, OpenAI actualmente genera unos ingresos estimados de 3.700 millones de dólares, mientras acumula pérdidas de aproximadamente 5.000 millones. Incluso su ambiciosa hoja de ruta, que proyecta ingresos de 100.000 millones para 2029, habla de ingresos totales, no de beneficios netos, lo que hace que el objetivo de AGI parezca más lejano de lo que Altman sugiere públicamente.

Esta definición tiene implicaciones estratégicas cruciales. El acuerdo entre Microsoft y OpenAI establece que la primera perderá acceso a la tecnología de OpenAI una vez se alcance la AGI. Al establecer una meta financiera tan elevada, Microsoft parece haber asegurado su acceso a largo plazo a la tecnología de OpenAI, mientras desarrolla simultáneamente sus propias alternativas.

Sam Altman y su predicción sobre el futuro de la IA

En una entrevista con The Free Press, Sam Altman, CEO de OpenAI, la compañía detrás de ChatGPT, ofrece su visión sobre cómo la IA está transformando nuestra vida cotidiana y su predicción del progreso futuro de la industria.

Mirando hacia el futuro, Altman plantea un panorama transformador para mediados de 2026, impulsado por el ritmo acelerado del progreso científico. Sin embargo, su visión no es distópica. "No cambiará los impulsos humanos fundamentales", asegura, "pero el mundo en el que existimos cambiará significativamente".

Esta perspectiva optimista se refleja en su visión sobre el futuro del trabajo. Altman hace una analogía histórica: "muchos de los trabajos que hacemos hoy habrían parecido pérdidas de tiempo triviales para la gente de hace unos cientos de años, pero nadie mira al pasado deseando ser un farolero". Del mismo modo, sugiere, las transformaciones laborales que traerá la IA podrían abrir nuevas oportunidades que hoy ni siquiera podemos imaginar.

Altman sugiere que el ritmo acelerado del progreso científico podría llevarnos a un punto de inflexión en tan solo 18 meses, para mediados de 2026. Esta predicción se alinea con declaraciones anteriores donde Altman ha sugerido que la superinteligencia - una IA que supere la capacidad humana en prácticamente todos los aspectos - podría emerger más rápido de lo que la mayoría espera. El factor clave, según Altman, es el efecto compuesto de los avances científicos: cada mejora en IA facilita el desarrollo de sistemas aún más avanzados, creando un ciclo de aceleración continua.

Sin embargo, Logan Kilpatrick, líder de producto en Google y una de los referentes más importantes de la industria de la IA respondió con un post en X en el que afirma que “el mundo lucirá sorprendentemente similar en 5 años, a pesar de la innovación tecnológica masiva posibilitada por la IA.”

Un uso práctico para la inteligencia artificial

Usar IA para encontrar IA

En medio de la explosión de herramientas de inteligencia artificial, encontrar la aplicación perfecta para nuestras necesidades puede resultar abrumador. "There's an AI for That" emerge como la solución a este problema, funcionando como un directorio curado que cataloga y organiza las mejores herramientas de IA disponibles en el mercado.

¿Cómo funciona? La plataforma permite a los usuarios buscar herramientas de IA por categorías específicas o casos de uso. Si necesitas una IA para editar videos, escribir contenido, generar imágenes o incluso componer música, el sitio te ayuda a encontrar la herramienta más adecuada para tu tarea.

Además, el sitio muestra reviews de los usuarios, puntuaciones, un resumen de los pros y contras y detalles sobre si la aplicación es gratuita o paga. Asimismo se ofrecen alternativas a dicha herramienta y un ranking de las herramientas mejor puntuadas por los usuarios para cada subsección disponible.

Para hacer uso de este recurso:

Visita thereisanaiforthat.com

Navega por categorías o utiliza la barra de búsqueda

Compara diferentes herramientas y sus funcionalidades

Accede directamente a la herramienta que mejor se ajuste a tus necesidades

Esta guía puede ahorrarte horas de búsqueda y ayudarte a descubrir herramientas que quizás no sabías que existían.

Los nuevos avances en la academia

Agentes: el futuro de la inteligencia artificial

Anthropic, la empresa creadora de Claude, acaba de revelar cómo las empresas están implementando esta nueva generación de asistentes de IA, llamados "agentes", que están revolucionando la forma en que interactuamos con la tecnología. A diferencia de los chatbots tradicionales, estos agentes pueden realizar tareas complejas de forma autónoma, tomando decisiones y adaptándose a diferentes situaciones.

Pero, ¿qué es exactamente un agente de IA? Imagina un asistente digital que no solo puede mantener una conversación, sino que también puede acceder a diferentes herramientas y bases de datos, tomar decisiones por sí mismo y ejecutar tareas completas sin necesidad de supervisión constante.

Anthropic acaba de publicar una guía detallada sobre la construcción de agentes de IA, revelando patrones clave que han emergido tras trabajar con docenas de equipos en diferentes industrias. Lo más sorprendente: los sistemas más exitosos no dependen de frameworks complejos, sino de patrones simples y componibles.

La compañía establece una distinción fundamental entre dos tipos de sistemas agénticos:

Los workflows: Sistemas donde las IAs y las herramientas siguen caminos de código predefinidos.

Los agentes: Sistemas donde las IAs dirigen dinámicamente sus propios procesos y uso de herramientas, manteniendo el control sobre cómo logran sus objetivos. La guía desmitifica varios conceptos erróneos sobre el desarrollo de agentes. Contrario a la creencia popular de que se necesitan frameworks especializados, Anthropic sugiere comenzar con implementaciones simples utilizando directamente las APIs de los modelos de lenguaje.

Lo más relevante de estas revelaciones es el énfasis en la simplicidad y la medición de resultados. Anthropic advierte contra la tentación de añadir complejidad innecesaria, sugiriendo que los desarrolladores solo deberían incrementar la sofisticación de sus sistemas cuando demuestren mejoras medibles en los resultados.

La arquitectura ideal de un agente se construye sobre varios patrones fundamentales:

El LLM aumentado: Un modelo de lenguaje mejorado con capacidades de recuperación de información, herramientas y memoria.

Encadenamiento de prompts: Descomposición de tareas en secuencias de pasos, donde cada llamada al LLM procesa la salida de la anterior.

Enrutamiento: Clasificación de entradas para dirigirlas a tareas especializadas.

Paralelización: Ejecución simultánea de subtareas independientes o múltiples intentos para obtener diversos resultados.

Orquestador-trabajadores: Un LLM central que descompone dinámicamente las tareas y las delega a otros LLMs.

Evaluador-optimizador: Un ciclo donde un LLM genera respuestas mientras otro proporciona evaluación y retroalimentación.

En 2025 esperamos que los agentes sean una palabra de mucho uso tanto en esta newsletter como en el uso cotidiano del consumidor y el uso corporativo.

Si te gustó esta newsletter te invitamos a suscribirte para recibir todas las semanas novedades, análisis y tips sobre todo lo nuevo que ocurre en la inteligencia artificial.

Si te interesa contactarnos, ya sea para adoptar inteligencia artificial en tu empresa, para aprender a usar los grandes modelos de lenguaje o para conocer más acerca de todo lo referido a la inteligencia artificial no dudes en comentar en este post. También puedes seguirnos en LinkedIn y en nuestra página web