El circulo virtuoso: Google presenta una IA que potencia la generación de nuevos modelos de IA

Resumen de las noticias más relevantes de la semana

OpenAI refuerza ChatGPT con GPT-4.1: nuevas capacidades para programación e inteligencia general

ChatGPT amplía sus funciones empresariales con análisis profundo en GitHub y SharePoint

AlphaEvolve: la IA de Google que crea algoritmos más eficientes que favorece el desarrollo de la propia IA

EE.UU. negociaría autorizar importación masiva de chips Nvidia a Emiratos Árabes

IBM automatiza recursos humanos con IA mientras Microsoft predice el fin del SaaS

Herramienta para maximizar el uso de la inteligencia artificial

Suno 4.5 lleva la creación musical con IA a nuevos niveles de calidad y expresividad

Nuevos avances científicos

HealthBench de OpenAI: un estándar riguroso para evaluar inteligencia artificial en salud

Lo que pasó esta semana

Google presenta AlphaEvolve: una IA que aprende a crear mejores algoritmos (y ya optimiza sus operaciones)

Google anunció AlphaEvolve, un sistema inteligente que utiliza la creatividad de modelos avanzados de inteligencia artificial para descubrir algoritmos más eficientes. Su objetivo principal es mejorar procesos clave en campos como la informática y las matemáticas, usando ideas que surgen de la propia IA y que luego son mejoradas continuamente mediante prueba y error automático.

El sistema opera en dos fases: primero, Gemini Flash explora diversas propuestas de código; después, Gemini Pro profundiza en las alternativas más prometedoras. Cada candidato se ejecuta y puntúa mediante métricas objetivas, y las mejores versiones alimentan iteraciones sucesivas.

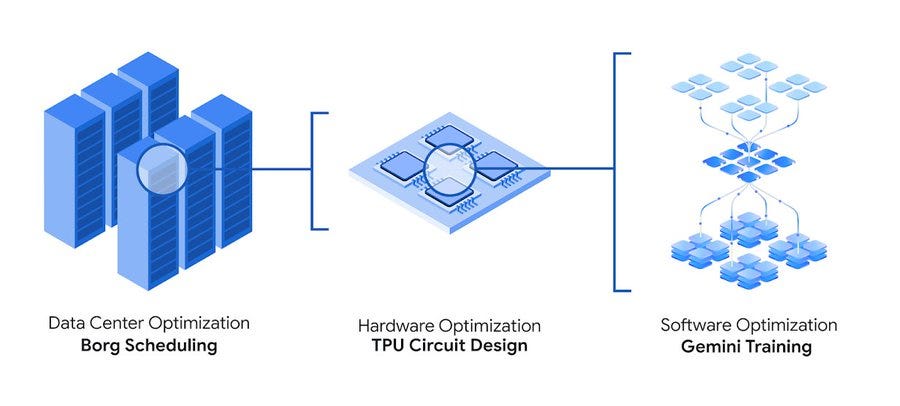

Para entender su importancia práctica, basta mirar los resultados en la infraestructura propia de Google. Gracias a AlphaEvolve, la empresa ya está optimizando cómo funcionan sus centros de datos. Concretamente, encontraron una forma sencilla pero eficaz de reorganizar automáticamente la distribución de tareas en estos centros, recuperando de forma sostenida un 0,7 % de toda la capacidad computacional global de la compañía. Aunque este porcentaje parezca pequeño, aplicado a la enorme escala operativa de Google implica miles de servidores aprovechados mejor cada día, con un ahorro considerable en recursos, energía y costos.

Además, AlphaEvolve ha contribuido a simplificar los circuitos de multiplicación matricial en chips especializados (TPUs), haciendo que las próximas generaciones de estos procesadores sean más rápidos y menos costosos de fabricar. Esto no es solo un avance técnico, sino que también permite fabricar chips más potentes y accesibles.

Otra aplicación directa e inmediata ha sido reducir en un 1 % el tiempo necesario para entrenar modelos avanzados de IA. Este porcentaje, aplicado a enormes proyectos como Gemini, equivale a ahorros significativos en tiempo, energía y dinero, acelerando además el ritmo de innovación en investigación tecnológica.

Desde un punto de vista matemático, AlphaEvolve ya mostró gran potencial: logró descubrir soluciones mejores que las conocidas para problemas abiertos desde hace décadas. Por ejemplo, mejoró un algoritmo clásico (de 1969) para multiplicar matrices de tamaño 4×4 con números complejos. Además, resolvió de manera inédita algunos problemas geométricos que llevaban siglos sin avances significativos.

Aunque pueda parecer solo una mejora más entre muchas, AlphaEvolve marca un cambio importante: los modelos de IA ya no solo responden preguntas o generan contenido, sino que ahora crean soluciones prácticas que impactan directamente en la eficiencia de procesos reales, desde hardware hasta investigación científica.

Finalmente, la evolución constante de estos modelos anticipa que, a medida que mejoran, producirán soluciones aún más valiosas. Google planea abrir pronto un acceso inicial para académicos, esperando que AlphaEvolve pueda extenderse a otras áreas como la ciencia de materiales, el descubrimiento de medicamentos o estrategias de sostenibilidad.

De esta manera AlphaEvolve no solo es importante por lo que hace hoy, sino por lo que abre hacia el futuro: un ciclo virtuoso donde cada mejora en IA acelera el desarrollo de la siguiente generación de inteligencia artificial.

OpenAI lanza sus modelos GPT-4.1 en ChatGPT

OpenAI anunció esta semana la incorporación de sus modelos GPT-4.1 y GPT-4.1 mini directamente en ChatGPT, tras haberlos lanzado inicialmente solo a través de su API para desarrolladores en abril.

El modelo GPT-4.1 está diseñado específicamente para destacar en tareas de programación. Según OpenAI, supera a GPT-4o en seguimiento de instrucciones precisas y desarrollo web, ofreciendo una alternativa a los modelos de razonamiento OpenAI o3 y o4-mini para necesidades de codificación más cotidianas. Este modelo ya está disponible para los usuarios de planes Plus, Pro y Team, mientras que los usuarios de Enterprise y Edu lo recibirán en las próximas semanas.

Por otra parte, GPT-4.1 mini reemplaza completamente a GPT-4o mini en la plataforma. La compañía describe este nuevo modelo como más rápido, capaz y eficiente, con mejoras significativas en seguimiento de instrucciones, codificación e inteligencia general. GPT-4.1 mini servirá como modelo de respaldo para usuarios gratuitos una vez que alcancen sus límites de uso de GPT-4o.

La introducción de estos modelos en ChatGPT llega en un momento de creciente atención hacia las herramientas de codificación con IA. Reportes recientes sugieren que OpenAI está cerca de anunciar la adquisición de Windsurf, una de las herramientas de codificación con IA más populares del mercado, por aproximadamente $3 mil millones.

Cabe destacar que el lanzamiento inicial de GPT-4.1 a través de su API en abril generó críticas de la comunidad de investigación en IA por no incluir un informe de seguridad. Los críticos argumentaban que OpenAI estaba reduciendo sus estándares de transparencia. Sin embargo, la empresa respondió que GPT-4.1 no es un modelo de frontera y no requiere el mismo nivel de informes de seguridad que modelos más avanzados.

Como parte de su esfuerzo por aumentar la transparencia, OpenAI se comprometió a publicar con mayor frecuencia los resultados de sus evaluaciones internas de seguridad de modelos de IA a través de su nuevo Safety Evaluations Hub, lanzado esta misma semana.

Nuevas funcionalidades de investigación profunda en ChatGPT

Paralelamente al lanzamiento de los modelos GPT-4.1, OpenAI continúa expandiendo las capacidades empresariales de ChatGPT con varias mejoras en su funcionalidad de investigación profunda (deep research).

La compañía ha introducido dos nuevos conectores para esta función: GitHub y SharePoint, ambos disponibles en fase beta para usuarios de ChatGPT Plus, Pro y Team. Estos conectores permiten que ChatGPT analice repositorios de código y documentos empresariales para generar informes completos con citas y fuentes.

Con el conector GitHub, los usuarios pueden vincular sus repositorios y solicitar análisis de codebases y documentación técnica. Por su parte, el conector SharePoint facilita la síntesis de contenido a través de múltiples sitios de SharePoint, lo que ayuda a reducir las barreras informativas entre departamentos.

OpenAI también ha añadido la capacidad de exportar los informes de investigación profunda como archivos PDF con formato completo, incluyendo tablas, imágenes, citas vinculadas y fuentes.

Este lanzamiento es parte de una serie constante de actualizaciones que OpenAI ha realizado en los últimos meses, incluyendo mejoras en GPT-4o, la introducción de OpenAI o3 y o4-mini para razonamiento avanzado, y la presentación del modelo GPT-4.5 en febrero.

EE.UU. cerca de autorizar a Emiratos Árabes la importación de 500.000 chips avanzados de Nvidia al año

Estados Unidos está próximo a alcanzar un acuerdo preliminar con Emiratos Árabes Unidos (EAU) que permitiría a este país del Golfo Pérsico importar 500.000 chips de IA de última generación de Nvidia por año, comenzando en 2025. Este acuerdo, que se extendería al menos hasta 2027 con posibilidad de prolongarse hasta 2030, representaría un cambio significativo en la política de exportación de tecnología estadounidense.

Según la información disponible, el acuerdo aún está en fase de negociación y contempla que un 20% de los chips (100.000 unidades anuales) se destinen a G42, la empresa tecnológica de Abu Dhabi especializada en inteligencia artificial. El 80% restante se distribuiría entre compañías estadounidenses como Microsoft y Oracle, que podrían establecer centros de datos en Emiratos Árabes.

Este volumen de chips supondría un gran aumento respecto a lo permitido bajo las restricciones impuestas por la administración Biden, que había limitado la exportación de semiconductores avanzados para evitar su posible desvío a países como China. La semana pasada, la administración Trump anunció su intención de revocar estas regulaciones previas.

El acuerdo también contempla beneficios para la infraestructura tecnológica estadounidense, ya que establecería que por cada instalación que G42 construya en Emiratos Árabes, deberá edificar una similar en Estados Unidos.

Los chips en cuestión corresponderían a las unidades de procesamiento gráfico más avanzadas, que actualmente incluyen los Nvidia Blackwell, más potentes que la generación anterior Hopper, o incluso los futuros chips Rubin de Nvidia, que superarían a ambos predecesores.

Este movimiento se produce en un contexto donde la mayor parte de la capacidad de cómputo para IA se concentra en Estados Unidos y China. Si este acuerdo y otros similares en la región del Golfo se concretan, el área podría emerger como un tercer centro de poder en la competencia global por la inteligencia artificial.

La noticia se conoce mientras el presidente Trump realiza una gira por la región del Golfo, donde ya anunció compromisos por valor de 600.000 millones de dólares con Arabia Saudita, incluyendo acuerdos para la compra de grandes cantidades de chips de Nvidia, AMD y Qualcomm. Fortalecer los lazos con los países del Golfo ha sido un objetivo clave de la actual administración estadounidense.

Fuentes cercanas a las negociaciones indican que el acuerdo enfrenta una creciente oposición dentro del gobierno estadounidense. Ni el Departamento de Comercio de EE.UU., que supervisa los controles de exportación, ni la Casa Blanca, G42, Emiratos Árabes Unidos o Nvidia han realizado comentarios oficiales al respecto.

La transformación del trabajo empresarial: IBM reemplaza empleados con IA mientras Satya Nadella predice el fin del SaaS

IBM ha confirmado recientemente que utilizó inteligencia artificial para reemplazar a cientos de empleados del departamento de recursos humanos. Sin embargo, según explicó su CEO Arvind Krishna al Wall Street Journal, esto no ha reducido la plantilla total de la empresa, sino que la ha aumentado. "Aunque hemos hecho una enorme cantidad de trabajo dentro de IBM para aprovechar la IA y la automatización en ciertos flujos de trabajo empresariales, nuestro empleo total en realidad ha subido, porque hemos logrado obtener más capacidad de inversión para cubrir otras áreas", afirmó Krishna.

La herramienta de IA que permitió esta transformación es AskHR, un sistema que IBM comenzó a implementar en 2021 y que ahora gestiona el 94% de las tareas rutinarias de recursos humanos. Esta automatización ha liberado recursos que la compañía ha reinvertido en contratar más programadores y personal de ventas, áreas consideradas estratégicas para el futuro de la organización.

Este caso ilustra que a veces la IA no necesariamente reduce el empleo total, sino que lo reconfigura, eliminando ciertos roles mientras crea demanda de otros nuevos más enfocados en aprovechar las capacidades de esta tecnología.

En paralelo a esta transformación operativa, Satya Nadella, CEO de Microsoft, anticipa cambios aún más profundos en la estructura misma del software empresarial. Durante una reciente entrevista en el podcast BG2, Nadella predijo que los agentes de IA pronto reemplazarán a las aplicaciones de software tradicionales (SaaS), transformando fundamentalmente cómo funcionan las empresas.

"El modelo SaaS o las aplicaciones empresariales y la noción de que las aplicaciones empresariales existen, probablemente colapsará en la era de los agentes", explicó Nadella. Según su visión, las aplicaciones empresariales son esencialmente bases de datos CRUD (Crear, Leer, Actualizar, Eliminar) con lógica de negocio integrada, y esta lógica pronto será manejada por agentes de IA.

La predicción de Nadella sugiere que, en lugar de interactuar con interfaces de usuario predefinidas, los trabajadores del futuro instruirán a agentes inteligentes que ejecutarán tareas interactuando directamente con múltiples bases de datos. Estos agentes no discriminarán entre diferentes backends, ya que podrán actualizar varias bases de datos simultáneamente, con toda la lógica operativa residiendo en lo que él denomina "la capa de IA".

Microsoft ya está avanzando en esta dirección con productos como la integración de Python en Excel, donde Copilot funciona como un asistente inteligente dentro de la hoja de cálculo, utilizando el intérprete de Python para tareas avanzadas. Este modelo podría evolucionar hasta generar experiencias completas a través de intérpretes de código.

Un uso práctico para la inteligencia artificial

Suno v4.5: La IA para crear música evoluciona con nueva calidad y expresividad

Suno, la herramienta de IA para crear música que presentamos en ediciones anteriores de nuestro newsletter, acaba de lanzar su versión 4.5 con significativas mejoras en la calidad y versatilidad de las composiciones generadas.

Esta actualización del modelo hace que la creación musical mediante inteligencia artificial sea más accesible e intuitiva, mejorando especialmente en la expresividad de las composiciones, la precisión y variedad de géneros, y la riqueza de las voces generadas.

Entre las principales novedades destacan la expansión de géneros musicales, permitiendo a los usuarios experimentar con estilos como "punk rock", "jazz house" o incluso "canto gregoriano" con mayor fidelidad. Los usuarios pueden ahora combinar géneros dispares, como "emo del medio oeste con neosoul" o "EDM con folk", obteniendo fusiones coherentes y creativas.

Las voces generadas también han dado un salto cualitativo, con mayor rango y profundidad emocional, logrando desde interpretaciones íntimas y delicadas hasta poderosas entregas vocales con vibrato.

Además, la nueva versión incorpora un asistente para mejorar los prompts, que ayuda a transformar ideas de género simples en descripciones detalladas. Otra característica notable es la posibilidad de combinar las funciones de Covers (versiones) y Personas para reimaginar canciones existentes con diferentes estilos vocales y estructurales.

Quizás lo más práctico para los usuarios sea la mejora en la velocidad de generación y la extensión de la duración máxima de las canciones, ahora de hasta 8 minutos manteniendo la coherencia y calidad a lo largo de toda la pieza.

Para quienes buscan experimentar con la creación musical sin conocimientos técnicos previos, Suno representa una herramienta cada vez más potente que permite materializar ideas musicales a partir de descripciones textuales, llevando la democratización de la creación artística a un nuevo nivel.

Los nuevos avances en la academia

OpenAI lanza HealthBench: un nuevo estándar para evaluar IA en salud

El sector de la salud se perfila como uno de los campos donde la inteligencia artificial podría generar mayor impacto. Reconociendo esta oportunidad, OpenAI acaba de presentar HealthBench, un nuevo benchmark diseñado específicamente para medir las capacidades de los sistemas de IA en escenarios médicos y de salud.

Este estándar de evaluación, desarrollado en colaboración con 262 médicos que han ejercido en 60 países, incluye 5.000 conversaciones realistas sobre salud, cada una con una rúbrica personalizada creada por médicos para calificar las respuestas de los modelos de IA.

HealthBench se basa en la premisa de que las evaluaciones para sistemas de IA en salud deben ser significativas (reflejando escenarios de la vida real), confiables (alineadas con el juicio médico profesional) e insaturadas (permitiendo el progreso continuo de los modelos).

Las conversaciones en HealthBench simulan interacciones entre modelos de IA y usuarios individuales o clínicos. Cubren siete áreas temáticas clave, como situaciones de emergencia, comunicación adaptada a distintos niveles de experiencia médica, respuestas bajo incertidumbre, y salud global, entre otras. Esta diversidad temática permite evaluar múltiples dimensiones del comportamiento de los modelos, desde la precisión y calidad de comunicación hasta la conciencia del contexto y la integridad de las respuestas.

Los resultados publicados muestran una mejora significativa en las capacidades de los modelos más recientes. OpenAI informa que su modelo o3 supera a otros competidores como Claude 3.7 Sonnet y Gemini 2.5 Pro, y que sus modelos de frontera han mejorado un 28% en HealthBench en los últimos meses.

Un hallazgo particularmente interesante es la comparación con respuestas escritas por médicos humanos. Los investigadores descubrieron que, mientras los médicos podían mejorar las respuestas de los modelos de septiembre de 2024 (como o1-preview y GPT-4o), ya no lograban superar la calidad de las respuestas proporcionadas por los modelos más recientes de abril de 2025 (o3 y GPT-4.1).

En cuanto a la confiabilidad de la evaluación, OpenAI encontró que el grado de acuerdo entre su calificador basado en IA y los médicos humanos es similar al nivel de acuerdo entre médicos individuales, lo que sugiere que HealthBench refleja adecuadamente el juicio médico experto.

Sin embargo, incluso los sistemas más avanzados todavía tienen un amplio margen de mejora, particularmente en la búsqueda de contexto necesario para consultas subespecificadas y en la confiabilidad del peor caso. Para promover el desarrollo colaborativo, OpenAI ha puesto a disposición de la comunidad científica el conjunto completo de evaluación y los datos subyacentes a través de su repositorio en GitHub.

Si te gustó esta newsletter te invitamos a suscribirte para recibir todas las semanas novedades, análisis y tips sobre todo lo nuevo que ocurre en la inteligencia artificial.

Si te interesa contactarnos, ya sea para adoptar inteligencia artificial en tu empresa, para aprender a usar los grandes modelos de lenguaje o para conocer más acerca de todo lo referido a la inteligencia artificial no dudes en comentar en este post. También puedes seguirnos en LinkedIn y en nuestra página web