Crisis interna en OpenAI por ignorar los riesgos de la inteligencia artificial

En esta newsletter exploraremos los debates éticos en torno a la IA que surgieron en la semana, junto con las integraciones de Copilot en todo el ecosistema de Microsoft.

En este newsletter exploraremos las últimas tendencias y avances en inteligencia artificial. Todas las semanas podrás encontrar:

Las noticias más relevantes de la semana en la industria de la inteligencia artificial.

Productos y herramientas gratuitas que permiten maximizar el uso de la inteligencia artificial en tu trabajo o vida personal.

Análisis sobre un artículo científico reciente en el campo de la inteligencia artificial, junto con las implicancias de estos nuevos descubrimientos.

En esta entrega, analizaremos los siguientes tópicos:

Renuncias en OpenAI ante la falta de atención a los riesgos del progreso tecnológico en inteligencia artificial.

Microsoft integra Copilot en todos sus productos, pudiéndose ahora utilizar GPT-4o en todo en Windows, incluyendo Teams, Outlook, OneDrive y Edge.

ChatGPT incorpora una funcionalidad que permite generar gráficos interactivos y hacer análisis de datos.

La Union Europea publicó su primer regulación en inteligencia artificial.

Lo que pasó esta semana

Renuncias masivas en el equipo de alineamiento de OpenAI

En 2023, OpenAI creó un equipo de superalineamiento debido a la urgente necesidad de controlar los próximos sistemas de IA, cuyas altas capacidades podrían implicar mayores riesgos para la humanidad. OpenAI presentaba la creación de este equipo de la siguiente manera:

Necesitamos avances científicos y técnicos para dirigir y controlar sistemas de inteligencia artificial mucho más inteligentes que nosotros. Para resolver este problema en cuatro años, vamos a formar un nuevo equipo, codirigido por Ilya Sutskever y Jan Leike, y dedicaremos el 20 % de la computación que hemos obtenido hasta la fecha a este esfuerzo.

La superinteligencia será la tecnología de mayor impacto que la humanidad haya inventado jamás y podría ayudarnos a resolver muchos de los problemas más importantes del mundo. Pero el vasto poder de la superinteligencia también podría ser muy peligroso y conducir a la pérdida de poder de la humanidad o incluso a su extinción.

Si bien la superinteligencia parece lejana ahora, creemos que podría llegar en esta década. Gestionar estos riesgos requerirá, entre otras cosas, nuevas instituciones para la gobernanza y la solución del problema de la alineación de la superinteligencia.

Esta semana los principales lideres de este equipo han renunciado.

Jan Leike, exjefe de alineación en OpenAI, anunció su salida criticando la dirección de la empresa al no priorizar adecuadamente los riesgos asociados con la inteligencia artificial avanzada. Destacó la urgencia de enfocarse en la preparación para la inteligencia artificial general, así como en la seguridad y el impacto social del desarrollo de estas tecnologías, advirtiendo que OpenAI no está en el camino correcto para abordar estos temas.

Recordemos que, hace meses, la junta directiva de OpenAI intentó destituir a Sam Altman, su actual CEO, debido a preocupaciones sobre su prioridad en el rápido desarrollo tecnológico en detrimento de la seguridad en la implementación de nuevos modelos. Illya Sutskever, cofundador de OpenAI y líder del equipo de superalineamiento junto con Leike, también anunció su salida de la compañía tras meses de inactividad en redes sociales. Sutskever fue uno de los principales impulsores del intento de desplazamiento de Altman.

El objetivo de OpenAI, y de casi todos los investigadores de IA, es llegar a la inteligencia artificial general (AGI, por sus siglas en inglés). Este es un tipo de IA teórica que implicaría que la máquina tenga habilidades cognitivas generales como razonamiento, resolución de problemas, aprendizaje, percepción y comprensión del lenguaje, todo ello a un nivel comparable o superior al humano. La AGI sería capaz de aplicar su inteligencia a cualquier área o problema, adaptándose y aprendiendo de manera autónoma. Las consecuencias de llegar a modelos de estas características no deben tomarse a la ligera, ya que el lanzamiento poco cuidadoso de modelos cercanos a AGI podría tener consecuencias muy negativas si no se mitigan los riesgos.

Mientras que algunos, como Leike, afirman la necesidad urgente de pensar en un desarrollo seguro de estos productos, y de preparar al mundo para la llegada de tecnologías avanzadas cada vez más parecidas a la AGI, otros, como Yann LeCun, un destacado investigador en el campo de la inteligencia artificial que actualmente trabaja en Meta, expresaron su opinión sobre los dichos de Leike y las críticas recibidas a OpenAI, afirmando que la urgencia de controlar los sistemas de IA es infundada, y que las compañías hacen bien en no destinar grandes recursos a estos equipos de superalineamiento.

LeCun comparó la situación actual con imaginar en 1925 la necesidad urgente de controlar aviones capaces de transportar cientos de pasajeros a velocidades cercanas a la del sonido sobre los océanos, cuando aún no se había inventado el turbojet ni ningún avión había cruzado el Atlántico sin escalas. Según LeCun, el proceso será similar para los sistemas inteligentes.

Mientras algunos, como Leike, afirman que estamos cerca de llegar a modelos que superen en una gran variedad de tareas a la inteligencia humana, LeCun advierte que no se debe confundir la acumulación y recuperación de conocimientos sobrehumanos de los actuales LLMs con una inteligencia real. Para el científico de Meta llevará años implementar y ajustar estos sistemas, y las compañías harían mejor en destinar sus recursos en el desarrollo de estos modelos, en vez de en la precaución sobre tecnologías que todavía no están desarrolladas.

Así, los investigadores de IA se encuentran divididos. Gente como LeCun es más pesimista respecto a las posibildiades revolucionarias de estas tecnologias en el corto plazo. Pero entre los más optimistas respecto a las posibilidades de llegar a una AGI existen quienes, como Leike o Elon Musk, ven en el progreso de la inteligencia artificial un grave peligro para la humanidad, y otros, como Sam Altman, que ven a la AGI como un avance positivo que implicará una revolución sin precedentes y llevará a un mayor progreso de la civilización.

En una reciente entrevista, Sam Altman, al ser consultado sobre su mayor debilidad como CEO reconoció que tiene una tendencia a estar a favor de la tecnologia debido a que tiene curiosidad y quiere ver hacia donde van los avances. Altman afirma que en última instancia la tecnología es algo bueno que mejorará el bienestar de la población, pero de todas maneras reconoce el sesgo pro tecnología como una posible debilidad.

Luego del post de Leike, Altman reconoció que OpenAI tiene mucho por mejorar en este aspecto, mientras que otro cofundador, Greg Brockman, presentó un comunicado afirmando que la compañía nunca dejó de lado sus preocupaciones por la seguridad del desarrollo tecnológico.

Sin embargo, quienes se encuentran dentro de la compañía están observando cómo OpenAI se está enfocando en alcanzar la AGI, priorizando cada vez menos la mitigación de riesgos inherentes a la creación de una tecnología tan avanzada.

Denuncia

Por otro lado, la actriz Scarlett Johansson ha denunciado penalmente a OpenAI debido a las similitudes que la voz de GPT-4o tiene con la suya. En un comunicado, Scarlett Johansson afirmó que Sam Altman le ofreció ser la voz oficial de ChatGPT, oferta que ella rechazó por razones personales. Sin embargo, la actriz acusa a OpenAI debido a las similitudes en la voz, a pesar de haber rechazado la oferta.

El comunicado incluso remarca el hecho de que Sam Altman hizo alusión a que ChatGPT-4o se parece al modelo de IA utilizado en la aclamada película "Her" en la cual la actriz da voz a un asistente de IA muy similar al presentado por OpenAI.

Microsoft integra Copilot en todos sus productos

Microsoft ha anunciado una importante actualización de todos sus productos, incorporando capacidades de IA que prometen revolucionar la forma en que interactuamos con nuestros dispositivos. Según Satya Nadella, CEO de Microsoft, esta innovación podría tener un impacto tan significativo como el que tuvo Windows 95 en su momento, permitiendo a los usuarios comunicarse con sus ordenadores de una manera más natural e intuitiva.

Entre las novedades, se anunció una integración total entre Copilot y todo el ecosistema Microsoft. Estas son algunas de las actualizaciones que serán públicas en el corto plazo:

Interacción en tiempo real con Copilot mientras se navega por diferentes aplicaciones. Por ejemplo, podremos pedirle ayuda verbalmente a la hora de navegar por internet o jugar un videojuego.

Traducciones en tiempo real y subtítulos en directo durante las videollamadas.

Encontrar documentos faltantes o recuperar pestañas en las que se hizo clic hace semanas con una nueva herramienta de recuperación.

Integración de Copilot en todas las aplicaciones de Microsoft como Teams, Outlook, OneDrive, Edge, etc., permitiendo nuevas funcionalidades únicas, como las que se observan a continuación:

Esta nueva innovación es posible gracias, además de la continúa mejora en tecnología, a la implementación por parte de Microsoft de Recall, un software que toma continuamente capturas de pantalla de tu dispositivo, con el objetivo de saber qué estás haciendo, permitiendo que pueda asistirte con Copilot. Esto no estuvo exento de controversia. Además del furor que generó en redes sociales, el regulador de datos del Reino Unido Information Commissioner's Office (ICO) está llevando a cabo una investigación sobre Recall y pedirá más información sobre las medidas de seguridad de esta función, ya que algunos defensores de la privacidad han expresado preocupaciones sobre los posibles riesgos para la privacidad.

Por otro lado, Microsoft anunció nuevas computadoras creadas específicamente para aprovechar al máximo las nuevas tecnologías de IA: las PC Copilot Plus de Microsoft. Estos dispositivos estarán equipados con el chip Snapdragon X Elite de Qualcomm, lo que les permitirá superar en rendimiento al MacBook Air M3 de Apple, líder del sector, con una mejora del 58% en velocidad y una batería de larga duración.

Estas mejoras se deben a la incorporación de procesadores especiales llamados NPU, diseñados específicamente para sacarle el máximo provecho al progreso de la inteligencia artificial. Estos avances representan un paso significativo hacia los dispositivos "AI-first", en los que la inteligencia artificial se integra desde el principio en el diseño y desarrollo de los productos, en lugar de añadirse como una característica adicional.

GPT-4o se posiciona como el mejor modelo

La semana pasada te mostramos en detalle cómo va a funcionar el modelo GPT-4o, que ahora se puede utilizar de manera gratuita para todos los usuarios de ChatGPT. Si bien OpenAI ha recibido varías críticas debido a que algunas de las características presentadas, principalmente las de audio, todavía no se encuentran disponibles, lo cierto es que incluso sin esas capacidades, el modelo sigue siendo superior al resto de los modelos disponibles.

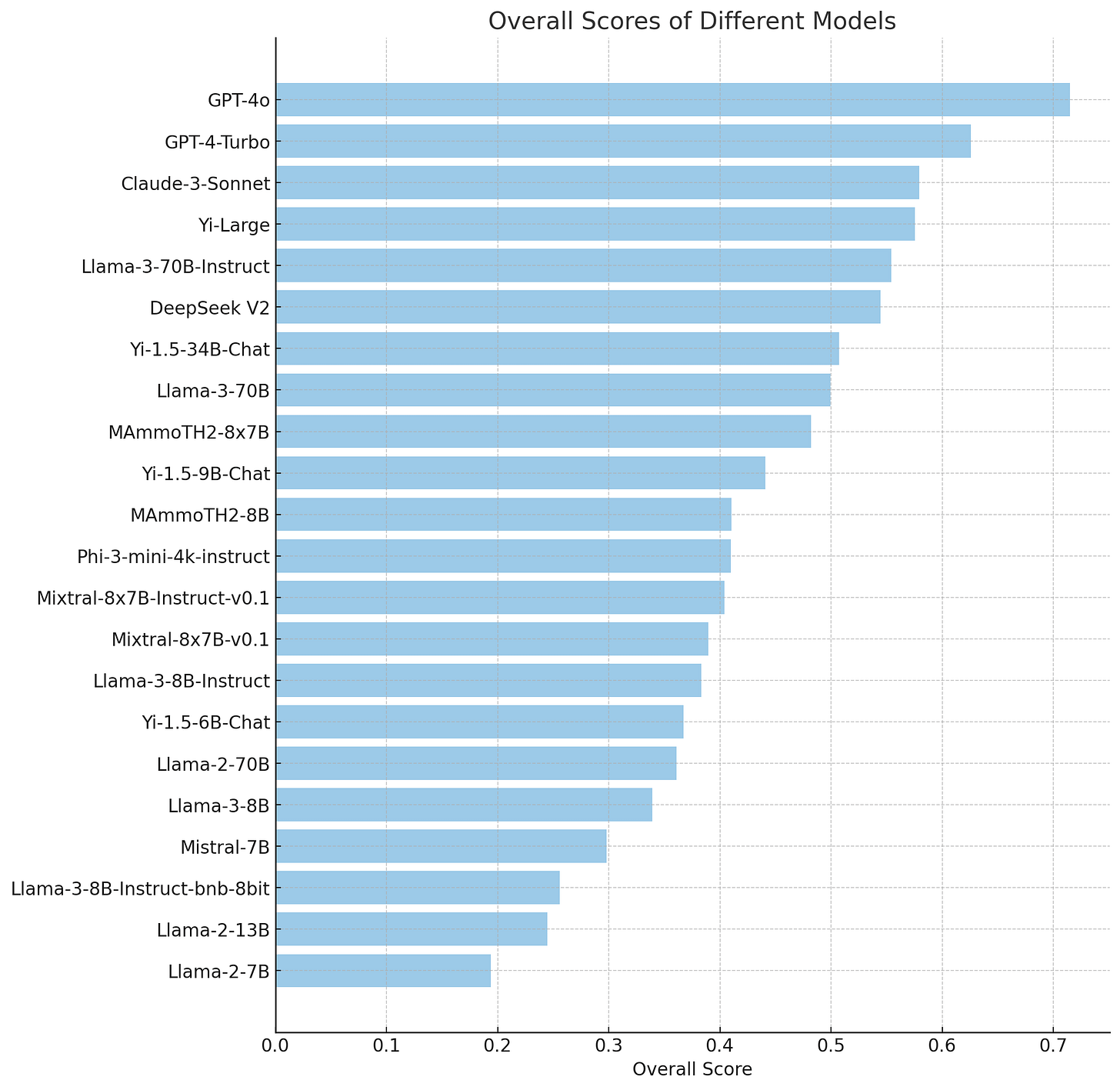

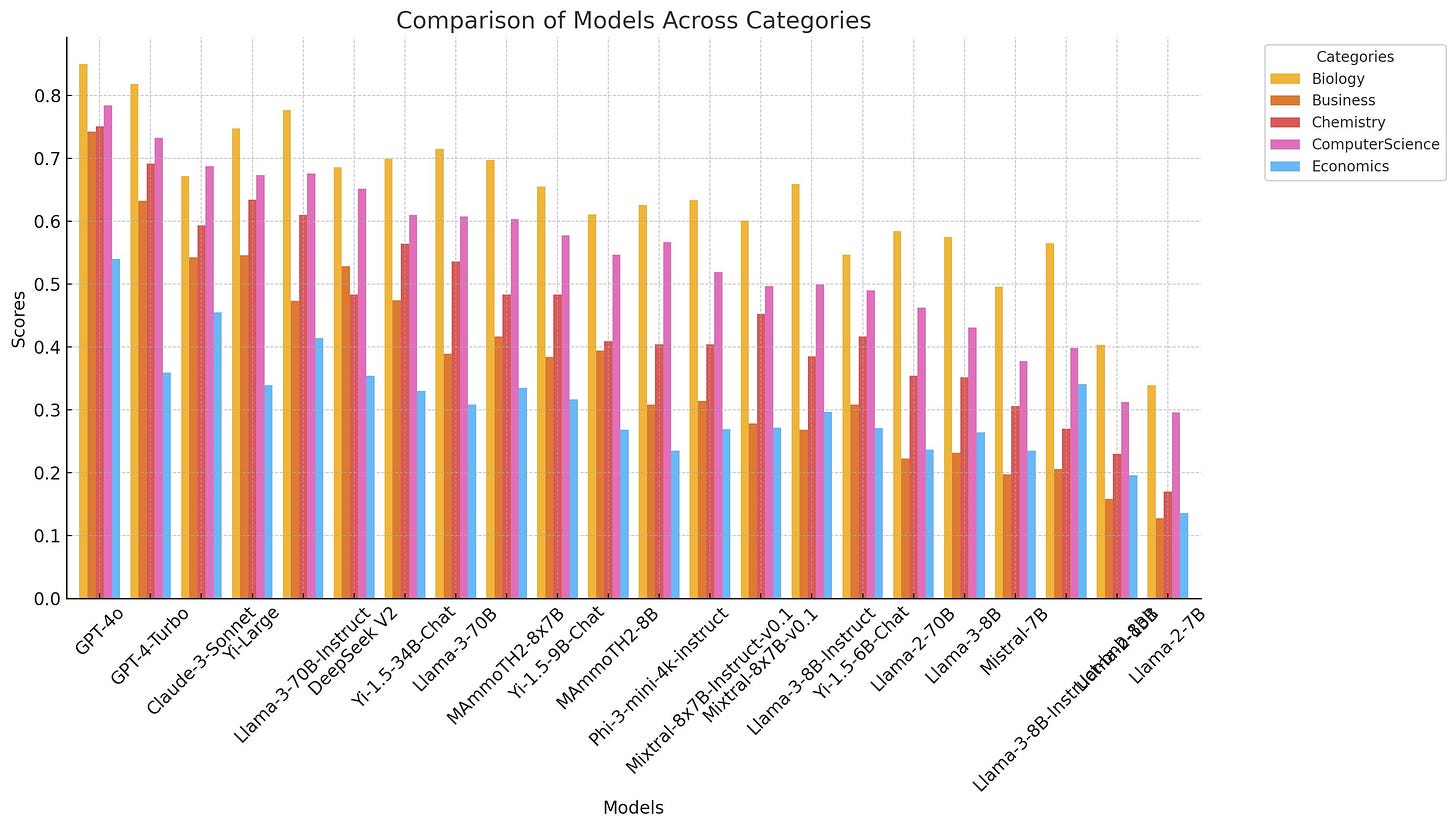

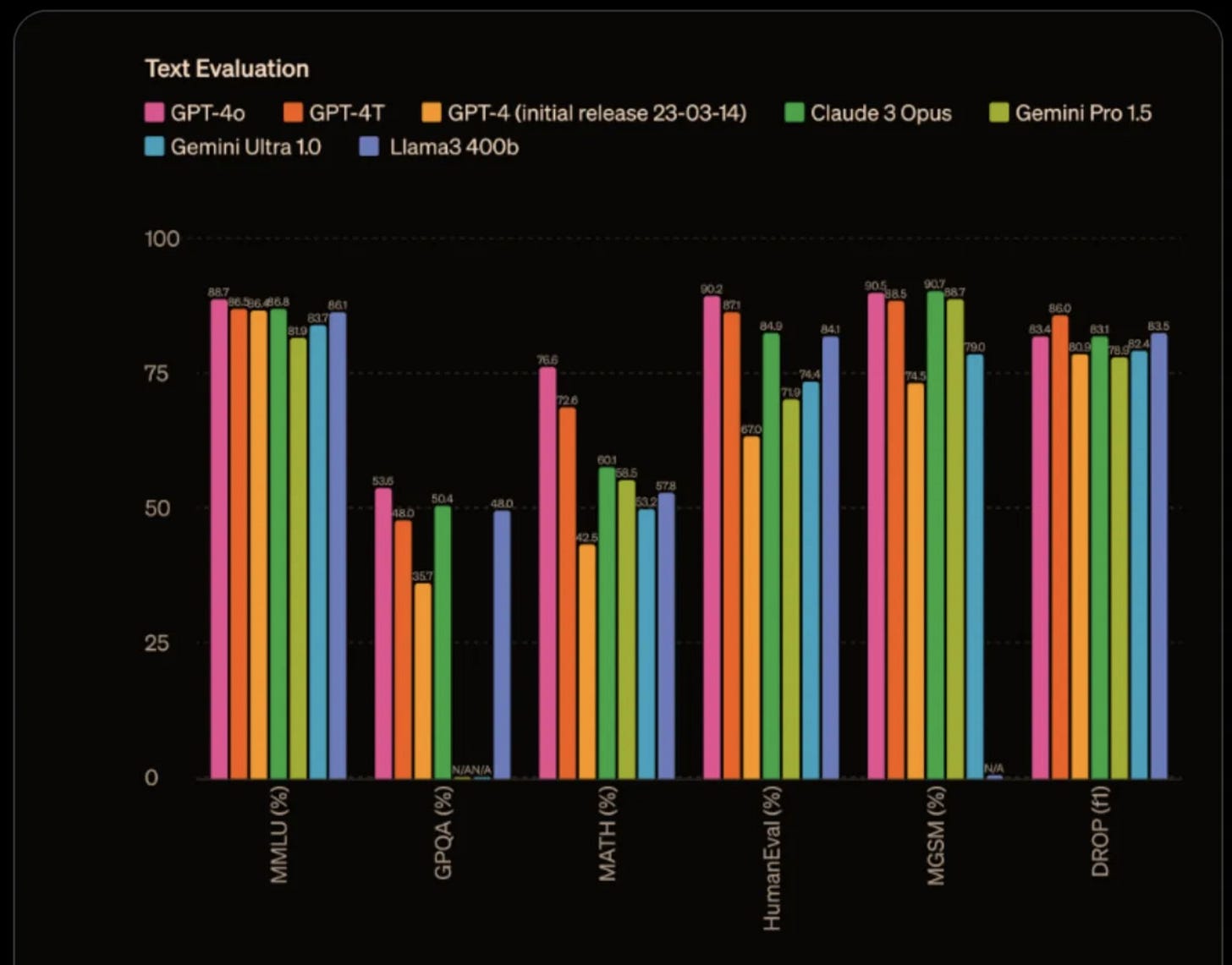

Como puede observarse en las siguientes imágenes, el nuevo modelo de OpenAI es el modelo con mejores capacidades de la actualidad:

Esto se evidencia no solo de manera general, sino a través de diversas categorías:

Las altas capacidades de ChatGPT-4o no solo se reflejan en los benchmarks habituales, que han sido sujetos de controversia debido a las dudas sobre la eficiencia de estas pruebas para medir de manera correcta la capacidad de estos modelos, sino que también se comprueba por varias pruebas hechas por usuarios, como por ejemplo la siguiente, que evalúa las capacidades de comprensión de texto:

GPT-4o no solo es el modelo más rápido y, según Microsoft, uno de los más eficientes en términos de costo. Si todavía no has probado este modelo, te invitamos a darle una oportunidad. Simplemente tienes que entrar a ChatGPT y ya podrás interactuar por defecto con el nuevo modelo. Los usuarios gratuitos tienen límites de mensajes, que se van actualizando cada ciertas horas. Los usuarios de pago cuentan con 5 veces más capacidad para interactuar con este modelo.

Un uso práctico para la inteligencia artificial

Nuevas funciones de ChatGPT

Gráficos interactivos

ChatGPT ha incorporado una nueva funcionalidad para los usuarios de pago que permite generar gráficos interactivos, mejorando significativamente el análisis de datos. Esta herramienta puede crear gráficos personalizados y tablas interactivas basadas en conjuntos de datos, lo que facilita la comprensión y manipulación de la información. Ahora los usuarios pueden visualizar datos en gráficos de barras, tablas dinámicas y más, haciendo clic en diferentes partes de los gráficos para obtener detalles adicionales y realizar consultas específicas.

Además, ChatGPT es compatible con Google Sheets, Docs, Slides, Excel, Word y PowerPoint, y puede integrarse con servicios de almacenamiento en la nube como OneDrive y Google Drive. Esta actualización está diseñada para usuarios de planes de pago, pero se espera que en el futuro esté disponible también para la versión gratuita. La capacidad de generar y manipular gráficos interactivos hace de ChatGPT una herramienta aún más poderosa para profesionales que necesitan analizar y presentar datos de manera eficiente y precisa.

Respuestas particulares

Si bien el nuevo modelo de OpenAI tiende a dar respuestas demasiado largas y exhaustivas (esto mejora la capacidad del modelo), una nueva característica presentada por la compañía líder en IA hace que la interacción con el modelo sea más cómoda y práctica.

Así como en WhatsApp o Telegram se puede seleccionar un mensaje particular para que el otro usuario sepa a qué responde el mensaje que acabamos de mandar, ahora la nueva función de "responder" en ChatGPT-4o te permite obtener respuestas más precisas y específicas a tus preguntas.

Para usar esta función, simplemente tienes que seleccionar una parte (palabra, oración, párrafo o lo que tú quieras) de la respuesta que te ha dado ChatGPT y al hacer click en el icono “Responder” podrás hacerle una consulta a ChatGPT específicamente sobre esa parte de su a veces larga respuesta.

Los nuevos avances en la academia

Europa presenta la primera regulación de IA

La Unión Europea ha aprobado el AI Act, una ley pionera en la regulación de la inteligencia artificial. Esta normativa clasifica los sistemas de IA en tres diferentes categorías según su nivel de riesgo: riesgo inaceptable, alto riesgo y mínimo riesgo.

Los sistemas de IA que entran en la categoría de riesgo inaceptable se prohíben explícitamente. Algunos ejemplos son:

Categorización biométrica basada en datos sensibles y la extracción no dirigida de imágenes faciales de Internet o CCTV para crear bases de datos de reconocimiento facial.

Reconocimiento de emociones en el lugar de trabajo y las escuelas, puntuación social y vigilancia policial predictiva.

IAs que manipulen el comportamiento humano o exploten las vulnerabilidades de las personas.

Los sistemas de alto riesgo, como los utilizados en infraestructura crítica, educación y empleo, por ejemplo, una herramienta de escaneo de CV que clasifica a los solicitantes de empleo, deberán cumplir estrictos requisitos de transparencia y supervisión humana para garantizar la seguridad y los derechos fundamentales.

Por último, las aplicaciones de mínimo riesgo que no están explícitamente prohibidas o catalogadas como de alto riesgo quedan en gran medida sin regular.

Por otro lado, los sistemas de IA de propósito general (GPAI), y los modelos GPAI en los que se basan, deben cumplir ciertos requisitos de transparencia, incluidos:

Cumplimiento de la ley de derechos de autor de la UE.

Publicación de resúmenes detallados del contenido utilizado para la capacitación.

La ley también establece la creación de un comité de expertos que supervisará la implementación de la normativa y asesorará sobre nuevas tecnologías emergentes. Este comité jugará un papel crucial en la actualización de las regulaciones conforme avanza la tecnología, asegurando que la legislación se mantenga relevante y efectiva.

Las empresas que no cumplan con los requisitos del AI Act enfrentarán sanciones severas, incluyendo multas de hasta el 7% de su facturación global anual. La Comisión Europea tendrá la autoridad para realizar auditorías y exigir la retirada de productos que no cumplan con los estándares establecidos. Con esta ley, la UE busca no solo proteger a sus ciudadanos, sino también establecer un estándar global para el desarrollo ético y responsable de la inteligencia artificial.

Sin embargo, hay críticos que sostienen que una concentración tan masiva en la regulación desincentivará la innovación y provocará que Europa se quede atrás de sus competidores, como Estados Unidos o China, que están avanzando a pasos agigantados.

Si te gustó esta newsletter te invitamos a suscribirte para recibir todas las semanas novedades, análisis y tips sobre todo lo nuevo que ocurre en la inteligencia artificial.

Si te interesa contactarnos, ya sea para adoptar inteligencia artificial en tu empresa, para aprender a usar los grandes modelos de lenguaje o para conocer más acerca de todo lo referido a la inteligencia artificial no dudes en comentar en este post. También puedes seguirnos en LinkedIn y en nuestra página web