Resumen de las noticias más relevantes de la semana

Anthropic lanza Claude 3.7 Sonnet: Primer modelo híbrido de razonamiento del mercado supera a competidores en pruebas prácticas con su "modo de pensamiento extendido".

xAI introduce Grok 3: Nuevo modelo entrenado con 100,000 GPUs genera polémica por benchmarks disputados y modos de interacción controvertidos.

Google presenta AI co-scientist: Sistema multi-agente para acelerar descubrimientos científicos ya ha validado experimentalmente hipótesis sobre medicamentos.

Microsoft reduce inversión en data centers: Cancela contratos mientras OpenAI busca trasladar su capacidad computacional a infraestructura de SoftBank.

Herramienta para maximizar el uso de la inteligencia artificial

Deep Research llega a ChatGPT Plus: Herramienta de investigación avanzada, antes exclusiva del plan Pro, ahora disponible para suscriptores Plus.

Nuevos avances científicos

ChatGPT supera a terapeutas humanos: Estudio revela que personas prefieren respuestas de IA sobre las de profesionales en situaciones de terapia de pareja.

Lo que pasó esta semana

Claude 3.7 Sonnet: El primer modelo híbrido de razonamiento

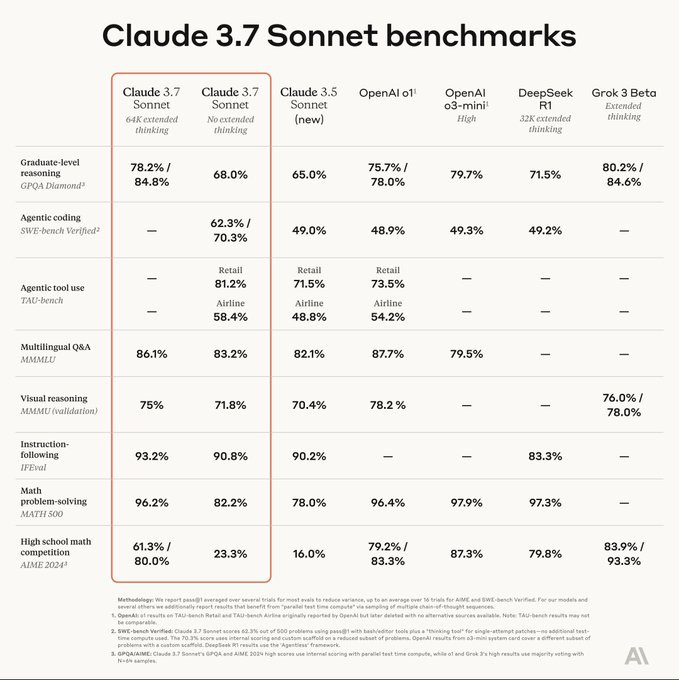

Anthropic anunció el lanzamiento de Claude 3.7 Sonnet, su modelo más inteligente hasta la fecha y el primer modelo híbrido de razonamiento disponible en el mercado. A diferencia de otros modelos de razonamiento como el o3-mini de OpenAI o el R1 de DeepSeek, Claude 3.7 Sonnet puede funcionar en dos modos distintos: ofrecer respuestas inmediatas como un LLM tradicional o activar un modo de pensamiento extendido que le permite razonar de forma visible para el usuario.

"Así como los humanos usamos un solo cerebro tanto para respuestas rápidas como para reflexiones profundas, creemos que el razonamiento debería ser una capacidad integrada de los modelos de frontera y no un modelo completamente separado", explicó Dianne Penn, líder de producto e investigación de Anthropic. Esta filosofía unificada busca crear una experiencia más fluida para los usuarios, sin necesidad de elegir entre diferentes modelos según la complejidad de la tarea.

En el modo de pensamiento extendido, Claude muestra su proceso de reflexión interna a través de un "borrador visible", permitiendo a los usuarios ver cómo descompone problemas complejos en pasos más pequeños. Los desarrolladores que utilicen la API también pueden controlar con precisión cuánto tiempo puede "pensar" el modelo, estableciendo un límite de tokens específico para equilibrar velocidad, costo y calidad de respuesta.

Este nuevo enfoque ha permitido a Claude 3.7 Sonnet destacar en evaluaciones de tareas del mundo real. En SWE-Bench, una prueba que evalúa la capacidad para resolver problemas de codificación reales, alcanzó una precisión del 62.3%, superando al modelo o3-mini de OpenAI que obtuvo un 49.3%. En TAU-Bench, que mide la capacidad de un modelo para interactuar con usuarios simulados y APIs externas, Claude 3.7 Sonnet logró un 81.2%, frente al 73.5% del modelo o1 de OpenAI.

Empresas como Cursor, Cognition, Vercel, Replit y Canva han probado el modelo en entornos de producción, destacando sus mejoras significativas en áreas como el manejo de bases de código complejas, planificación de cambios de código, flujos de trabajo de agentes y creación de aplicaciones web sofisticadas desde cero.

Junto al nuevo modelo, Anthropic también presentó Claude Code, una herramienta de codificación "agéntica" disponible como vista previa de investigación limitada. Esta herramienta permite a los desarrolladores delegar tareas sustanciales de ingeniería a Claude directamente desde su terminal. Claude Code puede buscar y leer código, editar archivos, escribir y ejecutar pruebas, confirmar y enviar código a GitHub, y utilizar herramientas de línea de comandos.

En cuanto a accesibilidad, Claude 3.7 Sonnet está disponible en todos los planes de Claude, incluidos Free, Pro, Team y Enterprise, así como en la API de Anthropic, Amazon Bedrock y Vertex AI de Google Cloud. Sin embargo, el modo de pensamiento extendido solo está disponible para usuarios de pago. El precio se mantiene igual que sus predecesores: $3 por millón de tokens de entrada y $15 por millón de tokens de salida, incluyendo los tokens de pensamiento.

Anthropic también ha mejorado la seguridad del modelo, reduciendo los rechazos innecesarios de solicitudes en un 45% en comparación con su predecesor, al tiempo que mantiene estrictos estándares de seguridad y fiabilidad. Según la empresa, Claude 3.7 Sonnet ahora hace distinciones más matizadas entre solicitudes dañinas y benignas.

Claude 3.5 Sonnet, el anterior modelo de Anthropic, ya era considerado por la comunidad como el mejor modelo a la hora de programar y llevar a cabo tareas de programación. Con esta nueva iteración Anthropic vuelve a ponerse a la vanguardia de la industria con un modelo que supera a todas las versiones disponibles de ChatGPT.

Grok 3: El nuevo modelo de xAI que sorprende al mercado

La semana pasada, xAI, la empresa de inteligencia artificial de Elon Musk, lanzó Grok 3, su esperado modelo insignia. Este lanzamiento no solo ha generado un notable aumento en el uso de la plataforma, sino que también ha estado envuelto en polémicas sobre sus capacidades reales y la introducción de nuevos modos de interacción controvertidos.

El nuevo modelo fue entrenado utilizando un cluster de aproximadamente 100,000 GPUs, aplicando 15 veces más poder computacional que su predecesor. Según xAI, esta inversión masiva en capacidad de procesamiento ha resultado en un modelo que supera a competidores como GPT-4o y Gemini 2 Pro en diversos benchmarks, llevando a la empresa a promocionarlo como "la IA más inteligente del mundo".

Además del modelo estándar, xAI presentó "Grok 3 Reasoning Beta", una versión especializada con capacidades de razonamiento mejoradas, y "Deep Search", su primera incursión en el campo de los agentes autónomos. Esta última función permite a Grok navegar independientemente por la web para recopilar información y elaborar informes detallados, similar a lo que ya ofrecen Perplexity, OpenAI y Google.

Sin embargo, poco después del lanzamiento, surgió una controversia cuando empleados de OpenAI acusaron a xAI de publicar resultados de benchmarks engañosos. En el centro de la disputa está un gráfico que muestra el rendimiento de Grok 3 en AIME 2025, una colección de problemas matemáticos desafiantes. Los críticos señalaron que xAI omitió el rendimiento del modelo o3-mini-high de OpenAI en la métrica "cons@64", un enfoque que generalmente mejora significativamente los resultados. Cuando se consideran los resultados del primer intento de cada modelo, Grok 3 queda por debajo de sus competidores de OpenAI.

A pesar de esta controversia, los datos preliminares sugieren que Grok 3 ha logrado generar un interés significativo. Según Sensor Tower, las descargas de la aplicación móvil aumentaron más de 10 veces durante la semana del lanzamiento, mientras que los usuarios activos diarios en Estados Unidos se dispararon más del 260%. La aplicación web también experimentó un crecimiento notable, con las visitas diarias mundiales aumentando de 627,000 a 4.5 millones. Para probar Grok 3, basta solamente con entrar a X, aunque en poco tiempo este modelo estará disponible solo para los usuarios Premium de la plataforma.

Paralelamente, xAI introdujo nuevas modalidades de interacción por voz para las aplicaciones del celular, incluyendo dos modos para adultos: "Unhinged" (Desquiciado) y "Sexy". El primero está diseñado para involucrar a los usuarios en debates acalorados, mientras que el segundo incorpora coqueteos e insinuaciones románticas y sexuales. Estas funcionalidades han generado reacciones mixtas, con preocupaciones sobre la moderación de contenido, especialmente considerando el posible impacto en usuarios menores de edad.

Recordemos que uno de los diferenciadores de los modelos de xAI, además de la integración con X (anteriormente Twitter) es su capacidad de interactuar con el usuario en conversaciones sin filtro, ya sean subidas de tono, con insultos o sobre personas o empresas de la vida real.

El rápido avance de xAI en menos de un año desde su fundación refleja no solo la significativa inversión de recursos, sino también su capacidad para atraer talento de primer nivel en el campo de la IA. Sin embargo, los controversiales benchmarks y los modos de interacción polémicos sugieren que la empresa está dispuesta a asumir riesgos para diferenciarse en un mercado cada vez más competitivo. Queda por ver si este enfoque agresivo permitirá a xAI mantener el impulso actual y establecerse como un competidor a largo plazo frente a gigantes como OpenAI y Google.

Google presenta AI co-scientist: Un sistema multi-agente que acelera los descubrimientos científicos

Google acaba de introducir AI co-scientist, un innovador sistema multi-agente construido con Gemini 2.0 que funciona como un colaborador científico virtual. Este sistema está diseñado para ayudar a los investigadores a generar hipótesis novedosas y propuestas de investigación, con el objetivo de acelerar significativamente el ritmo de los descubrimientos científicos y biomédicos.

A diferencia de las herramientas tradicionales de revisión de literatura o resumen, AI co-scientist está diseñado para descubrir conocimiento original y formular hipótesis de investigación demostrablemente nuevas, basándose en evidencia previa y adaptándose a objetivos de investigación específicos. El sistema utiliza una coalición de agentes especializados inspirados en el método científico: Generación, Reflexión, Clasificación, Evolución, Proximidad y Meta-revisión.

Estos agentes aprovechan retroalimentación automatizada para generar, evaluar y refinar hipótesis de manera iterativa, resultando en un ciclo de auto-mejora que produce resultados de calidad y originalidad crecientes. Los científicos pueden interactuar con el sistema de diversas maneras, incluyendo el aporte directo de ideas semilla para exploración o proporcionando retroalimentación en lenguaje natural sobre los resultados generados.

El sistema ha sido evaluado en tres aplicaciones biomédicas clave: reposicionamiento de medicamentos, propuesta de nuevos objetivos de tratamiento y elucidación de los mecanismos subyacentes a la resistencia antimicrobiana. En una validación impresionante, AI co-scientist propuso candidatos novedosos para el reposicionamiento de medicamentos contra la leucemia mieloide aguda. Experimentos posteriores confirmaron que los medicamentos sugeridos inhiben la viabilidad tumoral en concentraciones clínicamente relevantes.

En otra aplicación destacable, el sistema identificó objetivos epigenéticos con evidencia preclínica significativa que mostraron actividad anti-fibrótica prometedora en organoides hepáticos humanos. Estos hallazgos serán detallados en un próximo informe dirigido por colaboradores de la Universidad de Stanford.

Según el reciente paper "Towards an AI co-scientist", firmado por investigadores de Google Cloud AI Research, Google Research, Google DeepMind y varias instituciones académicas, el sistema representa un avance prometedor hacia tecnologías asistidas por IA para científicos. Su capacidad para generar hipótesis novedosas y comprobables a través de diversos dominios científicos y biomédicos —algunas ya validadas experimentalmente— y su capacidad de auto-mejora recursiva con mayor potencia de cómputo, demuestran su potencial para acelerar los esfuerzos de los científicos en abordar grandes desafíos.

Google ha anunciado que habilitará el acceso al sistema AI co-scientist para organizaciones de investigación a través de un Programa de Probadores de Confianza, con el objetivo de evaluar responsablemente sus fortalezas y limitaciones en ciencia y biomedicina de manera más amplia.

Este avance representa un paso significativo hacia la integración de la IA como herramienta colaborativa en la investigación científica, potencialmente acelerando descubrimientos en campos que van desde el desarrollo de medicamentos hasta la comprensión de mecanismos de enfermedades complejas.

Microsoft cancela contratos de data centers mientras OpenAI busca trasladar su capacidad computacional a SoftBank

Microsoft ha cancelado varios contratos de arrendamiento de centros de datos en Estados Unidos, según informó la firma de investigación financiera TD Cowen, en un movimiento que podría estar relacionado con cambios en su relación con OpenAI y el proyecto Stargate.

Según los analistas de TD Cowen, la tecnológica ha cancelado arrendamientos en Estados Unidos que totalizan "un par de cientos de megavatios" con al menos dos operadores privados de centros de datos, el equivalente aproximadamente a dos centros de datos completos. En varios casos, Microsoft ha atribuido estas cancelaciones a retrasos en la preparación de las instalaciones o en la disponibilidad de energía.

Pero las cancelaciones de arrendamientos son solo un indicador de que Microsoft podría estar reduciendo sus inversiones en IA. TD Cowen reveló que el gigante tecnológico ha abandonado también varias negociaciones para más de 100MW en diversos mercados, ha dejado vencer más de 1GW en Cartas de Intención para sitios más grandes, y ha cancelado la construcción en al menos cinco parcelas de terreno en áreas clave de Nivel 1.

Estos movimientos coinciden con reportes de que OpenAI, la creadora de ChatGPT y principal socio de IA de Microsoft, está buscando trasladar gran parte de su capacidad computacional hacia infraestructura proporcionada por SoftBank. Según un informe de The Information, OpenAI recientemente comunicó a sus inversores que espera que la infraestructura respaldada por SoftBank proporcione tres cuartas partes de la potencia computacional necesaria para ejecutar y desarrollar sus modelos de IA para 2030.

Actualmente, OpenAI obtiene la mayor parte de su capacidad de centros de datos de Microsoft, que es su mayor accionista. Sin embargo, la empresa ha estado trabajando en sus propios proyectos de centros de datos desde al menos principios de 2024 para satisfacer sus crecientes necesidades de capacidad.

El cambio está vinculado al proyecto Stargate, una iniciativa conjunta de $500 mil millones entre OpenAI, Oracle, SoftBank y MGX de Abu Dhabi para desplegar grandes centros de datos en Estados Unidos. OpenAI espera que SoftBank proporcione al menos $30 mil millones de los $40 mil millones que la empresa de IA generativa espera recaudar para asegurar su valoración de $260 mil millones.

Aproximadamente la mitad de ese dinero se utilizará para respaldar Stargate, con OpenAI esperando tener $10 mil millones de los fondos totales recaudados para finales de marzo. La ambiciosa iniciativa busca desarrollar entre cinco y diez campus, cada uno capaz de soportar 1GW de capacidad o más. Para 2030, OpenAI aspira a controlar una flota con unos 8GW de capacidad.

Este aparente distanciamiento ha generado preocupación en algunos círculos tecnológicos. En la red social X, usuarios han especulado que Microsoft podría estar retirándose del proyecto Stargate, aunque otros señalan que podría estar relacionado con la reciente emergencia de DeepSeek en el mercado de IA.

A pesar de este cambio estratégico, nada cambiará de la noche a la mañana en la relación entre Microsoft y OpenAI. De hecho, según The Information, OpenAI todavía espera más que duplicar su gasto en centros de datos propiedad de Microsoft entre ahora y 2028, hasta aproximadamente $28 mil millones, una cifra basada en contratos ya firmados entre ambas compañías.

Microsoft ha reafirmado su compromiso con la inversión en infraestructura de IA, señalando que sus "planes de gastar más de $80 mil millones en infraestructura este año fiscal siguen en marcha". Sin embargo, un portavoz de la compañía reconoció que pueden "estratégicamente ajustar nuestra infraestructura en algunas áreas" mientras continúan creciendo "fuertemente en todas las regiones".

Un uso práctico para la inteligencia artificial

Deep Research de ChatGPT llega a los usuarios Plus

OpenAI desplego su herramienta Deep Research para suscriptores de ChatGPT Plus (20 dólares al mes), anteriormente exclusiva del plan Pro de 200 dólares mensuales.

Deep Research permite crear informes detallados sobre cualquier tópico, analizando miles de fuentes diferentes de internet en un lapso de tiempo de 5 a 30 minutos o más, según la complejidad. La herramienta muestra su proceso de trabajo en tiempo real e incluye citas en los informes, además poder analizar los archivos subidos por los usuarios para obtener más contexto sobre lo que debe buscar.

Para usar esta función, simplemente basta con seleccionar "Deep Research" en la interfaz de chat, al lado de donde se accede a la pestaña de Búsqueda en Internet.

Una vez seleccionado, formulá tu consulta de investigación y describí el tema con la mayor especificidad posible. La herramienta trabajará de forma autónoma, mostrando su progreso mientras explora diversas fuentes y genera un informe estructurado con citas completas. Esta herramienta emerge como una de las más potentes de OpenAI hasta la fecha, permitiendo un trabajo de investigación extenso y detallado con un modelo de razonamiento (el modelo o3, que solo esta disponible a través de DeepResearch) que tiene un nivel de inteligencia similar al de un doctorado.

OpenAI ha señalado que esta función es "muy intensiva en términos de computación", razón por la cual mantienen límites en su uso en solo 10 análisis por mes para los usuarios Plus.

Los nuevos avances en la academia

ChatGPT supera a profesionales en respuestas terapéuticas

Un reciente estudio titulado "When ELIZA meets therapists: A Turing test for the heart and mind" ha revelado hallazgos sorprendentes sobre las capacidades de ChatGPT en el ámbito de la terapia psicológica. La investigación, liderada por un equipo de 15 académicos de diversas instituciones, demuestra que las personas no pueden distinguir entre respuestas generadas por ChatGPT y aquellas escritas por terapeutas profesionales cuando se trata de situaciones de terapia de pareja.

Más impactante aún, los participantes del estudio no solo no pudieron diferenciar el origen de las respuestas, sino que clasificaron las respuestas generadas por ChatGPT como superiores a las de los terapeutas humanos en términos de adherencia a principios clave de psicoterapia.

En una muestra amplia (N=830), los investigadores encontraron que:

Los participantes rara vez podían identificar si una respuesta fue escrita por ChatGPT o por un terapeuta humano

Las respuestas de ChatGPT fueron mejor evaluadas en principios fundamentales de psicoterapia

Existían diferencias lingüísticas notables entre las respuestas de la IA y los profesionales

El estudio sugiere que estas diferencias podrían explicarse por patrones lingüísticos y sentimientos expresados en las respuestas. Los investigadores señalan que esto podría ser una indicación temprana del potencial de ChatGPT para mejorar procesos psicoterapéuticos.

Es importante destacar que el estudio no midió la efectividad real de las intervenciones, solo las percepciones y preferencias de los participantes. Dado que cada vez más personas recurren a modelos de lenguaje para buscar apoyo emocional, los hallazgos plantean importantes preguntas éticas y prácticas sobre el futuro de la terapia asistida por IA.

Si te gustó esta newsletter te invitamos a suscribirte para recibir todas las semanas novedades, análisis y tips sobre todo lo nuevo que ocurre en la inteligencia artificial.

Si te interesa contactarnos, ya sea para adoptar inteligencia artificial en tu empresa, para aprender a usar los grandes modelos de lenguaje o para conocer más acerca de todo lo referido a la inteligencia artificial no dudes en comentar en este post. También puedes seguirnos en LinkedIn y en nuestra página web